Agenti AI per Contesti Lunghi: La Guida alla Memoria Dinamica con MemAgent

- Andrea Viliotti

- 4 ago 2025

- Tempo di lettura: 16 min

L'abilità di analizzare e comprendere vasti volumi di testo è una delle sfide più complesse per le attuali intelligenze artificiali. Sebbene i modelli linguistici di grandi dimensioni (LLM) abbiano mostrato capacità notevoli, la loro operatività è spesso limitata da una "finestra di contesto", ovvero la quantità di informazioni che possono elaborare simultaneamente. Questa limitazione strutturale impedisce di affrontare compiti come l'analisi di intere basi di conoscenza aziendali o report finanziari complessi. Una recente ricerca condotta da un team di studiosi di ByteDance e della Tsinghua University, tra cui Hongli Yu, Tinghong Chen, Jiangtao Feng, e altri, introduce un approccio innovativo, denominato MemAgent, che mira a superare questa barriera, dotando i modelli di una memoria dinamica e scalabile per creare agenti AI per contesti lunghi realmente efficaci.

1. La Sfida dei Contesti Lunghi: Un Limite Strategico per i Modelli AI

Per un dirigente d'azienda, l'idea di avere un'intelligenza artificiale in grado di leggere, comprendere e sintetizzare istantaneamente l'intera documentazione aziendale — contratti, manuali tecnici, report di mercato, email accumulate in anni — rappresenta un traguardo strategico. Tuttavia, la realtà tecnologica odierna si scontra con un ostacolo fondamentale: la limitata finestra di contesto dei modelli linguistici. La maggior parte degli LLM, anche i più avanzati, opera con una memoria a breve termine che può gestire poche migliaia o, nei casi migliori, qualche decina di migliaia di "token" (le unità di testo, assimilabili a parole o parti di esse). Superata questa soglia, il modello perde traccia delle informazioni iniziali, rendendo impossibile l'analisi di documenti estesi.

Il cuore del problema risiede nella complessità computazionale dell'architettura Transformer, la tecnologia alla base di quasi tutti gli LLM moderni. Il suo meccanismo di attenzione, che permette al modello di pesare l'importanza di ogni parola in relazione a tutte le altre, ha un costo che cresce in modo quadratico (O(N2)) all'aumentare della lunghezza del testo (N). In termini pratici, raddoppiare la lunghezza del documento non raddoppia il tempo di elaborazione, ma lo quadruplica. Questo non solo rende i costi proibitivi per testi molto lunghi, ma pone anche un limite fisico alle capacità di calcolo dell'hardware disponibile. Di conseguenza, le aziende si trovano con un patrimonio informativo enorme e prezioso, ma con strumenti che possono analizzarne solo piccoli frammenti alla volta, perdendo la visione d'insieme e le connessioni cruciali che emergono solo da un'analisi completa.

2. Soluzioni Attuali per i Contesti Lunghi: Un'Analisi dei Limiti Strutturali

Per aggirare i limiti della finestra di contesto, la comunità scientifica ha esplorato diverse direzioni, ciascuna con i propri compromessi. Comprendere queste alternative è fondamentale per un manager che deve valutare un investimento in tecnologia AI, poiché la scelta dell'approccio impatta direttamente su costi, performance e scalabilità.

Il primo filone è quello dell'estrapolazione della lunghezza. Tecniche come RoPE (Rotary Position Embedding) e le sue varianti (YaRN, DCA) cercano di "allungare" la finestra di contesto di un modello pre-addestrato, modificando il modo in cui vengono codificate le posizioni delle parole. Sebbene efficaci per estensioni moderate, queste soluzioni mostrano spesso un degrado delle prestazioni su testi estremamente lunghi. Il modello, addestrato su contesti più brevi, fatica a mantenere la coerenza e la precisione quando viene spinto molto oltre i suoi limiti originali.

Un secondo approccio si basa sull'attenzione sparsa (Sparse Attention). Invece di calcolare le connessioni tra ogni token e tutti gli altri (come fa l'attenzione standard), questi metodi si concentrano solo su pattern di attenzione predefiniti o dinamici, riducendo la complessità computazionale. Il limite di questa tecnica è che i pattern sono spesso basati su euristiche umane e potrebbero non catturare tutte le relazioni semantiche complesse e a lunga distanza presenti in un documento. Si tratta di un'ottimizzazione che rischia di sacrificare parte della profondità di comprensione.

Infine, vi sono le tecniche di compressione del contesto. L'idea è di condensare le informazioni di un lungo testo in un riassunto più breve (a livello di token) o di affidarsi a un modulo di memoria esterno. Questi approcci, pur essendo ingegnosi, spesso faticano a estrapolare le loro capacità e introducono una complessità aggiuntiva, interrompendo il flusso di generazione standard del modello. La compressione, per sua natura, implica una potenziale perdita di dettagli, che potrebbero rivelarsi cruciali per rispondere a una domanda specifica. Nessuna di queste soluzioni, quindi, risolve in modo definitivo il "trilemma" del contesto lungo: processare testi di lunghezza infinita, scalare senza perdere performance e mantenere un'efficienza di calcolo con complessità lineare.

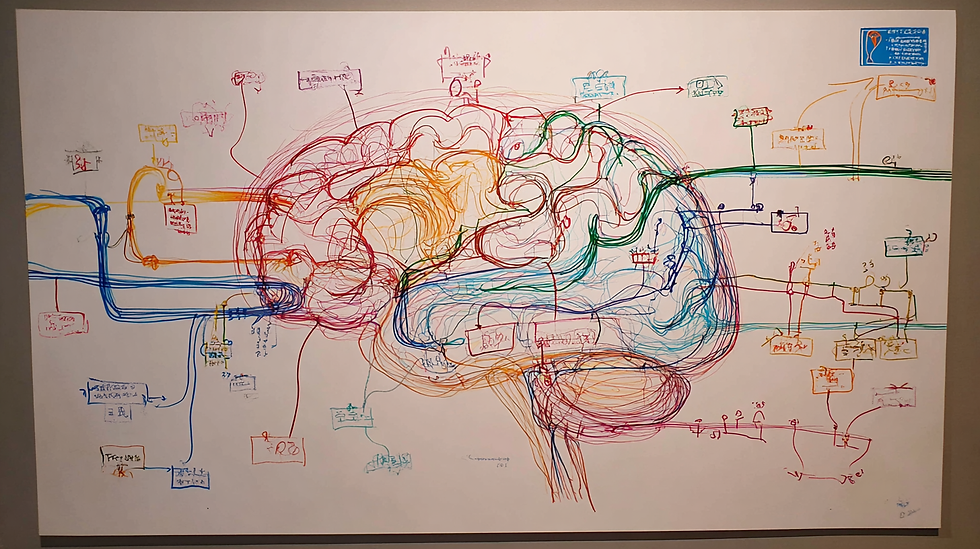

3. MemAgent: Come gli Agenti AI per Contesti Lunghi Imitano la Mente Umana

Di fronte ai limiti delle soluzioni esistenti, l'approccio di MemAgent si distingue per un cambio di prospettiva radicale, ispirato direttamente al modo in cui gli esseri umani gestiscono grandi quantità di informazioni. Quando leggiamo un libro o un lungo report, non tentiamo di memorizzare ogni singola parola. Piuttosto, identifichiamo i concetti chiave, prendiamo appunti mentali o fisici e aggiorniamo la nostra comprensione man mano che procediamo, scartando i dettagli ridondanti.

MemAgent replica questo processo. Invece di alimentare l'intero documento all'LLM in un unico blocco, il sistema lo suddivide in segmenti (chunk) più piccoli e gestibili. L'agente AI legge un segmento alla volta. Durante la lettura, il suo compito non è solo comprendere il testo, ma anche aggiornare una "memoria" a lunghezza fissa. Questa memoria, una sequenza di token dedicata all'interno della finestra di contesto, agisce come un blocco per gli appunti.

Il meccanismo chiave è la strategia di sovrascrittura (overwrite): dopo aver letto un nuovo segmento di testo, il modello non aggiunge informazioni alla memoria, ma la riscrive completamente, integrando le nuove informazioni rilevanti e conservando quelle importanti dai segmenti precedenti. Questo approccio, apparentemente semplice, è ciò che garantisce la scalabilità degli agenti AI per contesti lunghi. Poiché la dimensione della memoria rimane costante, il costo computazionale per ogni segmento è fisso (O(1)), e la complessità totale del processo diventa strettamente lineare (O(N)) rispetto al numero di segmenti. Questo significa che analizzare un documento di due milioni di parole costa circa il doppio di uno da un milione, un modello di costo prevedibile e sostenibile per un'azienda, a differenza della crescita esponenziale dei metodi tradizionali. In questo modo, qualsiasi LLM con una finestra di contesto moderata può essere trasformato in un potente strumento di analisi per contesti virtualmente illimitati.

4. Addestrare gli Agenti AI: Il Ruolo Decisivo dell'Algoritmo Multi-Conv DAPO

Avere un meccanismo di memoria è solo una parte della soluzione. La vera sfida è insegnare al modello cosa ricordare e cosa scartare. Un'informazione cruciale per rispondere a una domanda potrebbe trovarsi a pagina 3, mentre i dettagli per interpretarla correttamente sono a pagina 200. L'agente deve imparare a riconoscere e conservare il primo dato, ignorando centinaia di pagine di "rumore" intermedio. Qui entra in gioco l'Apprendimento per Rinforzo (Reinforcement Learning - RL).

Il processo di aggiornamento della memoria è formulato come un problema di RL: l'agente riceve una "ricompensa" se la memoria che costruisce passo dopo passo lo porta a generare la risposta finale corretta. Per ottimizzare questo comportamento, i ricercatori hanno esteso un algoritmo chiamato DAPO (Directly-Aligned Policy Optimization), creando il Multi-Conv DAPO. "Multi-Conv" sta per "multi-conversation", perché il processo di analisi di un singolo documento genera una serie di interazioni (conversazioni) indipendenti: una per ogni segmento di testo letto e aggiornamento della memoria, più una finale per la generazione della risposta.

L'algoritmo tratta ogni conversazione come un obiettivo di ottimizzazione indipendente. Il segnale di ricompensa, ottenuto solo alla fine (la risposta è giusta o sbagliata), viene propagato a ritroso per "premiare" o "penalizzare" tutte le decisioni di aggiornamento della memoria che hanno portato a quel risultato. Questo addestramento end-to-end permette al modello di sviluppare una capacità strategica di compressione delle informazioni, preservando i fatti critici per la risposta e scartando i distrattori. Navigare la complessità di un simile addestramento, definendo le giuste strategie di ricompensa e monitorando l'apprendimento dell'agente, richiede una guida esperta. Aziende di consulenza come Rhythm Blues AI si specializzano proprio nell'accompagnare le imprese in questi percorsi, traducendo le potenzialità di tecnologie avanzate come MemAgent in vantaggi competitivi concreti, garantendo che l'implementazione sia allineata agli obiettivi di business.

5. Definire il Successo: Come Funziona la Ricompensa per gli Agenti AI

Un sistema basato sull'Apprendimento per Rinforzo è efficace solo quanto il suo modello di ricompensa. Per un'azienda, questo concetto non è astratto, ma si traduce direttamente nella definizione di successo per un compito specifico. Se l'obiettivo è estrarre dati finanziari da report trimestrali, la "ricompensa" è legata alla precisione numerica. Se è rispondere a domande di assistenza basandosi su manuali tecnici, la ricompensa dipende dalla correttezza e completezza della risposta fornita.

Nel caso di MemAgent, i ricercatori hanno utilizzato un approccio chiamato RLVR (Reinforcement Learning from Verifiable Rules). Invece di affidarsi a feedback umano soggettivo, la ricompensa è calcolata da un "verificatore" basato su regole. Questo verificatore confronta la risposta generata dal modello con un set di risposte corrette (ground-truth).

La logica della ricompensa si adatta alla natura del compito. Per esempio, in un compito di domanda e risposta (Question Answering) in cui possono esistere più formulazioni della stessa risposta corretta, il modello riceve il punteggio massimo se la sua risposta è semanticamente equivalente ad almeno una delle risposte di riferimento. La formula può essere espressa come:

R(y_hat, Y) = max_{y in Y}(I(is_equiv(y, y_hat)))

Dove y_hat è la risposta del modello, Y è l'insieme delle risposte corrette e I è una funzione indicatore che vale 1 se la condizione è vera.

In altri scenari, come il "Multi-Value Needle in a Haystack" (trovare più "aghi" in un "pagliaio"), la domanda potrebbe richiedere di elencare tutti i valori associati a un certo dato. In questo caso, la ricompensa è proporzionale al numero di risposte corrette trovate rispetto al totale. La formula diventa:

R(y_hat, Y) = |{y in Y | I(y in y_hat)}| / |Y|

Questo approccio basato su regole chiare e verificabili rende l'addestramento oggettivo e allineato a risultati misurabili, un aspetto fondamentale per qualsiasi applicazione aziendale che richieda affidabilità e precisione.

6. Un Nuovo Paradigma per l'AI: Perché MemAgent è Strutturalmente Diverso

Per apprezzare appieno l'innovazione di MemAgent, è utile riconsiderare il funzionamento di un LLM standard. Un modello tradizionale è autoregressivo: genera una parola alla volta basandosi su tutte le parole precedenti. Questo crea una dipendenza storica che, come abbiamo visto, porta al collo di bottiglia dell'attenzione quadratica. Ogni token passato deve rimanere nel contesto attivo.

MemAgent modifica questo paradigma introducendo la memoria m come una variabile latente. La probabilità di generare un testo non è più calcolata su una sequenza continua, ma viene scomposta in un processo iterativo di lettura e scrittura. La probabilità congiunta viene fattorizzata in questo modo:

p(x_{1:N}) = sum_{m^{1:K-1}} product_{k=1}^{K} p(c^k | m^{k-1}) * p(m^k | c^k, m^{k-1})

Questa formula, pur apparendo complessa, descrive un processo intuitivo:

1. Per ogni segmento di testo c^k, la sua probabilità dipende dalla memoria precedente m^{k-1} (fase di lettura).

2. Successivamente, viene generata una nuova memoria m^k che dipende sia dal testo appena letto c^k sia dalla memoria precedente m^{k-1} (fase di scrittura).

La differenza cruciale rispetto ad altri approcci è che la memoria di MemAgent risiede nello spazio dei token. È testo, non un vettore di numeri nascosto e incomprensibile. Questo significa che ogni stato intermedio della memoria è leggibile e interpretabile da un essere umano. Un operatore può ispezionare cosa il modello ha deciso di ricordare a ogni passo, può correggerlo o analizzarlo per capire il suo processo decisionale. Questa "ispezionabilità" è un vantaggio enorme in contesti aziendali, dove la trasparenza, l'audit e la governance dei sistemi AI sono requisiti non negoziabili, specialmente alla luce di normative come l'AI Act europeo, che è attualmente in vigore.

7. Performance degli Agenti AI per Contesti Lunghi: I Risultati dei Test

L'efficacia di un nuovo approccio teorico deve essere convalidata da risultati empirici solidi. I test condotti su MemAgent dimostrano non solo la sua validità, ma anche una superiorità netta rispetto ai modelli di riferimento su compiti che richiedono l'analisi di contesti estremamente lunghi.

I ricercatori hanno utilizzato il benchmark RULER, un insieme di test sintetici progettati specificamente per valutare le performance dei modelli al crescere della lunghezza del contesto. I dati di addestramento sono stati creati utilizzando il dataset HotpotQA, inserendo le risposte corrette ("aghi") all'interno di un vasto numero di documenti distrattori ("pagliaio").

Il modello MemAgent è stato addestrato utilizzando una finestra di contesto di soli 8K token su documenti lunghi 32K token. Successivamente, è stato testato su documenti con una lunghezza crescente, fino a 3.5 milioni di token. I risultati, riassunti nella tabella seguente, sono eloquenti.

Modello | 7K | 112K | 448K | 896K | 1.75M | 3.5M |

Qwen2.5-Instruct-14B-1M | 60.16 | 17.19 | 8.59 | 0.00 | N/A | N/A |

DS-Distill-Qwen-14B | 64.06 | 23.44 | 3.12 | 6.25 | N/A | N/A |

RL-MEMAGENT-14B | 83.59 | 79.69 | 74.22 | 76.56 | 76.56 | 78.12 |

RL-MEMAGENT-7B | 82.03 | 72.66 | 75.00 | 77.34 | 75.78 | 71.09 |

Tabella 2: Accuratezza (%) su compiti di QA al variare della lunghezza del contesto. I valori mostrano come i modelli di base (Qwen, DS-Distill) subiscano un crollo delle performance, mentre MemAgent mantiene un'accuratezza elevata e stabile.

Come si può osservare, i modelli baseline, anche quelli progettati per contesti lunghi (fino a 1M di token), mostrano un rapido degrado delle prestazioni, arrivando a un'accuratezza nulla ben prima di raggiungere la loro capacità teorica. Al contrario, MemAgent (sia nella versione a 7 che a 14 miliardi di parametri) dimostra una straordinaria capacità di estrapolazione, mantenendo un'accuratezza quasi costante con una perdita di performance inferiore al 5% anche su contesti di 3.5 milioni di token. Questo risultato convalida l'efficacia del meccanismo di memoria unito all'apprendimento per rinforzo.

8. L'Importanza dell'Apprendimento per Rinforzo (RL) nella Gestione della Memoria

Per isolare il contributo specifico dell'addestramento con Apprendimento per Rinforzo, i ricercatori hanno condotto uno studio di ablazione, confrontando tre configurazioni di modelli:

1. Il modello base (Qwen2.5-Instruct) senza alcuna modifica.

2. Lo stesso modello equipaggiato con il meccanismo di memoria di MemAgent, ma senza l'addestramento RL.

3. Il modello completo di MemAgent, addestrato con RL.

I risultati di questo confronto sono illuminanti. Il modello base, come previsto, fallisce rapidamente all'aumentare della lunghezza del contesto. Il modello con il solo meccanismo di memoria mostra un miglioramento: è in grado di gestire contesti che superano la sua finestra nativa, ma le sue prestazioni diminuiscono progressivamente all'aumentare della lunghezza del testo. Questo indica che, sebbene la struttura di memoria a segmenti fornisca un'impalcatura utile, il modello non sa istintivamente come utilizzarla al meglio.

È solo con l'introduzione dell'addestramento RL che le performance diventano stabili e robuste. Il modello addestrato con RL mantiene un'accuratezza elevata e costante su tutte le lunghezze di contesto, con un degrado minimo. Questo dimostra che l'apprendimento per rinforzo è la componente essenziale che "insegna" al modello la strategia ottimale di gestione della memoria: come identificare, conservare e sintetizzare le informazioni critiche nel tempo. Per un'azienda, questo significa che non è sufficiente adottare un'architettura avanzata; il vero valore si sblocca attraverso un processo di addestramento mirato che allinei le capacità del modello agli obiettivi specifici del compito.

Punto Chiave: Il meccanismo di memoria fornisce la capacità di gestire contesti lunghi, ma l'Apprendimento per Rinforzo fornisce l'intelligenza per farlo in modo efficace.

9. Generalizzazione degli Agenti AI: I Test su Compiti Fuori Dominio (OOD)

Una preoccupazione legittima per qualsiasi dirigente è se una tecnologia, pur performante su un compito specifico, sia in grado di generalizzare le sue capacità ad altri problemi. Un modello addestrato solo su un tipo di domanda e risposta potrebbe non essere altrettanto efficace nel tracciare dati variabili o nell'estrarre informazioni da documenti con una struttura diversa.

Per verificare la capacità di generalizzazione di MemAgent, sono stati condotti esperimenti su un'ampia gamma di compiti "fuori dominio" (Out-of-Domain - OOD) del benchmark RULER. Questi includono diverse varianti del test "Needle-in-a-Haystack", il tracciamento di variabili (che richiede di seguire entità attraverso sequenze estese), l'estrazione delle parole più frequenti e un compito di Question Answering basato su un altro dataset (SQuAD).

I risultati mostrano che MemAgent mantiene performance superiori e stabili in tutte le categorie di compiti. In particolare, il modello MemAgent-14B raggiunge un'accuratezza media superiore al 95% su 10 diversi task RULER con contesti fino a 512K token. Anche la versione più piccola, MemAgent-7B, supera modelli molto più grandi che non utilizzano questo approccio. Questa performance consistente su compiti eterogenei convalida che il meccanismo di memoria non si limita a "imparare a memoria" un formato specifico, ma sviluppa una competenza generale e robusta nella gestione delle informazioni a lungo termine. Per un'impresa, questo si traduce in un investimento più sicuro e versatile, poiché la tecnologia può essere adattata a molteplici casi d'uso all'interno dell'organizzazione senza richiedere un riaddestramento completo da zero per ogni nuovo problema.

10. Agenti AI per Contesti Lunghi in Azione: Un Caso di Studio Pratico

Per rendere tangibile il funzionamento interno di MemAgent, analizziamo un caso di studio riportato nella ricerca. Il compito richiede di rispondere a una domanda "a due salti" (2-hop), che necessita di collegare informazioni da due fonti diverse.

Domanda: La regista della commedia romantica "Big Stone Gap" in quale città di New York risiede?

Per rispondere, il modello deve:

1. Scoprire chi è la regista di "Big Stone Gap".

2. Scoprire dove risiede quella persona.

Il modello analizza un lungo documento, segmento per segmento.

● Round 1: Il modello legge un segmento che parla di "Ghost", un team di produzione musicale con sede a New York. Sebbene non sia direttamente collegato alla regista, il modello identifica la parola chiave "New York" e, in via precauzionale, decide di conservare questa informazione nella sua memoria. Memoria Aggiornata: Ghost è un team di produzione basato a New York City.

● Round 2: Il modello incontra un segmento di testo non pertinente. Riconosce che non ci sono informazioni utili e, dimostrando robustezza alle distrazioni, lascia la sua memoria invariata.

● Round 3: Il modello riceve un segmento contenente due voci di Wikipedia cruciali:

○ Documento 81: "Big Stone Gap è un film del 2014 scritto e diretto da Adriana Trigiani."

○ Documento 96: "Adriana Trigiani è un'autrice... regista... con sede a Greenwich Village, New York City."A questo punto, l'agente identifica le informazioni critiche. Sovrascrive la sua memoria precedente, inserendo i nuovi dati e collegandoli. Memoria Aggiornata: La regista di "Big Stone Gap" è Adriana Trigiani, che risiede a Greenwich Village, New York City.

● Round successivi e Risposta Finale: Il ragionamento è completo. Nei segmenti successivi, la memoria rimane stabile. Quando il modello deve generare la risposta finale, consulta unicamente la sua memoria consolidata e risponde correttamente: Greenwich Village, New York City.

Questo esempio illustra perfettamente le capacità apprese dall'agente: stima la rilevanza potenziale delle informazioni, le immagazzina preventivamente, aggiorna la memoria non appena trova il dato esatto e ignora le informazioni irrilevanti.

11. Conclusioni: Le Implicazioni Strategiche degli Agenti AI per il Business

L'approccio incarnato da MemAgent non è un semplice miglioramento incrementale; rappresenta un passo significativo verso la realizzazione di un'intelligenza artificiale realmente capace di agire come partner strategico per le imprese. Le implicazioni per imprenditori e dirigenti sono profonde. La capacità di elaborare contesti di lunghezza virtualmente illimitata con costi lineari e prevedibili sblocca casi d'uso prima impensabili. Si può passare dall'analisi di singoli documenti a quella di intere basi di conoscenza, mettendo in correlazione dati provenienti da reparti diversi (legale, tecnico, marketing) per scoprire insight nascosti.

A differenza di tecnologie esistenti come i sistemi RAG (Retrieval-Augmented Generation), che recuperano frammenti di testo pertinenti ma possono perdere il contesto più ampio, agenti AI per contesti lunghi come MemAgent costruiscono una comprensione olistica e dinamica. La sua memoria, esplicita e ispezionabile, offre inoltre un livello di trasparenza fondamentale per la governance e la fiducia nei sistemi decisionali automatizzati.

Tuttavia, l'adozione di queste tecnologie non è banale. Richiede una visione strategica, competenze specialistiche per l'addestramento e l'integrazione, e un piano di change management per preparare l'organizzazione. Il vero valore non risiede nella tecnologia in sé, ma nella sua applicazione mirata a risolvere problemi di business concreti.

È qui che un partner come Rhythm Blues AI può fare la differenza. Il nostro approccio non è vendere una soluzione, ma fornire gli strumenti e le conoscenze per avviare un percorso strategico sull'IA. Attraverso un audit iniziale, identifichiamo le aree a maggior potenziale e costruiamo un percorso formativo e consulenziale su misura per CEO, proprietari di PMI e dirigenti. Il nostro obiettivo è trasformare la complessità tecnologica in un vantaggio competitivo misurabile, coniugando innovazione, sostenibilità economica e rispetto dei principi etici.

Se desidera esplorare come un'intelligenza artificiale avanzata possa contribuire concretamente ai progetti della sua azienda, la invitiamo a fissare una consulenza iniziale gratuita. Sarà un momento di scambio per analizzare i suoi bisogni e iniziare a costruire un piano d'azione personalizzato.

12. Domande Frequenti (FAQ) sugli Agenti AI per Contesti Lunghi

1. In cosa MemAgent è diverso da un sistema RAG (Retrieval-Augmented Generation)?Un sistema RAG recupera pezzi di informazione da una base dati e li inserisce nel contesto del modello per generare una risposta. MemAgent, invece, legge l'intero documento in sequenza e costruisce una memoria sintetica e dinamica, permettendogli di cogliere relazioni a lunghissimo raggio che un recupero frammentato potrebbe mancare.

2. Questa tecnologia è già disponibile sul mercato o è solo una ricerca accademica?Attualmente, MemAgent è un approccio di ricerca avanzato che dimostra una nuova metodologia. Sebbene non sia un prodotto "pronto all'uso", i principi e gli algoritmi possono essere implementati da team specializzati per creare soluzioni personalizzate per le aziende.

3. Qual è il principale vantaggio in termini di costi rispetto ai modelli tradizionali?Il vantaggio principale è la prevedibilità e la scalabilità dei costi. La complessità lineare (O(N)) di MemAgent significa che i costi di elaborazione crescono in proporzione diretta alla lunghezza del testo, a differenza della crescita quadratica (O(N2)) dei modelli standard, che rende l'analisi di testi molto lunghi economicamente insostenibile.

4. L'addestramento di un modello come MemAgent è un processo complesso?Sì, l'addestramento con Apprendimento per Rinforzo (RL) è significativamente più complesso di un fine-tuning standard. Richiede la definizione di modelli di ricompensa, un'infrastruttura di calcolo adeguata e competenze specifiche in RL, motivo per cui l'affiancamento di esperti è spesso cruciale.

5. La "memoria" di MemAgent può essere letta da un umano?Sì, e questo è uno dei suoi vantaggi principali. La memoria è costituita da token di testo, quindi è completamente trasparente e ispezionabile. Questo è fondamentale per il debugging, l'audit e per garantire l'affidabilità del modello.

6. Quali tipi di documenti aziendali sono più adatti per essere analizzati con questo approccio?Virtualmente qualsiasi documento di testo lungo: basi di conoscenza interne, archivi di contratti legali, report finanziari annuali, trascrizioni di call, manuali tecnici, documentazione di ricerca e sviluppo.

7. È necessario un hardware specifico per utilizzare un modello basato su MemAgent?MemAgent è progettato per funzionare su architetture Transformer standard, quindi non richiede hardware esotico. Tuttavia, come per tutti i grandi modelli linguistici, necessita di una potenza di calcolo significativa (GPU) per l'addestramento e l'inferenza.

8. Come si gestisce il rischio che il modello "dimentichi" un'informazione importante?Il rischio è mitigato dall'addestramento con Apprendimento per Rinforzo. Il modello viene premiato per aver conservato le informazioni che si rivelano utili per la risposta finale. Attraverso migliaia di esempi, impara una strategia efficace per decidere cosa è "importante" e cosa può essere scartato.

9. Questo approccio è conforme a normative come l'AI Act europeo?L'approccio stesso è una metodologia tecnica. La conformità dipende da come viene implementato e utilizzato. Tuttavia, la sua natura trasparente e ispezionabile (la memoria leggibile) fornisce strumenti utili per soddisfare i requisiti di accountability e trasparenza richiesti da normative come l'AI Act.

10. Quanto tempo potrebbe richiedere l'implementazione di un progetto pilota basato su questa tecnologia nella mia azienda?I tempi variano in base alla complessità del caso d'uso e alla maturità digitale dell'azienda. Un percorso tipico, come quelli proposti da Rhythm Blues AI, parte con un audit di poche ore, seguito da una fase di formazione e definizione strategica. Un proof of concept potrebbe richiedere da alcune settimane a qualche mese per essere sviluppato e testato.

Commenti