IA Generativa e Guida Autonoma: La Guida Strategica per il Business del Futuro

- Andrea Viliotti

- 19 ago 2025

- Tempo di lettura: 26 min

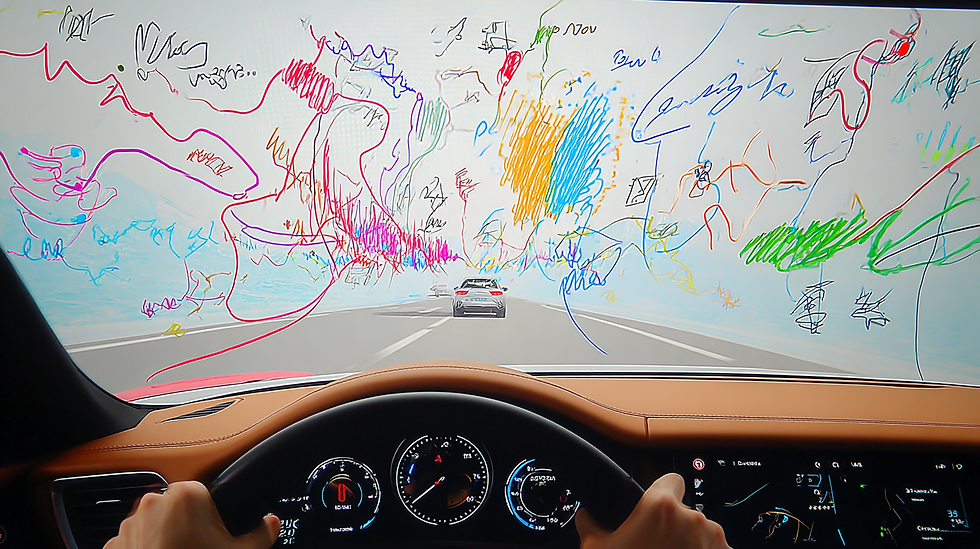

L'Intelligenza Artificiale Generativa (GenAI) sta ridefinendo numerosi settori industriali grazie alle sue capacità di creazione di contenuti, ragionamento e comprensione multimodale. Nel campo della guida autonoma, questa tecnologia non rappresenta un semplice aggiornamento, ma un approccio che potrebbe indirizzare una delle sfide ingegneristiche più complesse: il raggiungimento di un'autonomia di Livello 5, sicura e affidabile. Una recente e approfondita ricerca condotta da un consorzio di istituzioni accademiche e industriali, tra cui Texas A&M University, University of California, Stanford University e NVIDIA, ha mappato le frontiere e le opportunità di questa convergenza, fornendo un quadro essenziale per i leader aziendali che intendono navigare questo scenario.

1. IA Generativa e Guida Autonoma: Superare la Sfida della "Coda Lunga"

Il percorso verso la guida completamente autonoma è una maratona ingegneristica e strategica, non uno sprint. Per decenni, l'industria automobilistica ha compiuto progressi misurabili, introducendo sistemi avanzati di assistenza alla guida (ADAS) che rientrano nei livelli SAE 2 e 3. Questi sistemi, come il mantenimento della corsia e il cruise control adattivo, richiedono ancora la supervisione umana e operano in contesti definiti, come la guida in autostrada. Parallelamente, attori come Waymo, nata da un progetto della Stanford University che vinse la DARPA Grand Challenge nel 2005, e Baidu Apollo Go in Cina, hanno spinto la frontiera al Livello 4, implementando servizi di robotaxi senza conducente in aree urbane circoscritte. Queste implementazioni, sebbene significative, evidenziano un limite fondamentale che impedisce il salto al Livello 5, ovvero l'operatività illimitata in qualsiasi condizione.

La barriera principale è nota come il problema della "coda lunga" (long tail). I sistemi di guida autonoma tradizionali, basati su modelli di deep learning addestrati su enormi quantità di dati reali, faticano a generalizzare e a comportarsi in modo affidabile di fronte a eventi rari ma critici. Parliamo di condizioni meteorologiche estreme, illuminazione anomala, configurazioni di traffico impreviste o comportamenti umani imprevedibili. Raccogliere dati reali per coprire ogni possibile evenienza è logisticamente impossibile e proibitivamente costoso. È proprio per affrontare questa sfida che l'Intelligenza Artificiale Generativa (GenAI) si sta affermando come un approccio promettente.

A differenza dei modelli predittivi tradizionali, la sinergia tra IA Generativa e Guida Autonoma permette di sintetizzare nuovi dati e scenari con un elevato grado di realismo. Questa capacità permette di affrontare direttamente il problema della "coda lunga". Invece di attendere che un evento raro si verifichi nel mondo reale, è possibile generarlo sinteticamente in innumerevoli varianti, creando dataset di addestramento ricchi e diversificati. L'avvento di modelli come DALL-E, Midjourney e Stable Diffusion nel campo visivo, e di modelli linguistici di grandi dimensioni (LLM) come ChatGPT e LLaMA, ha dimostrato un potenziale che va oltre la semplice creazione di contenuti. Per la guida autonoma, questi strumenti non sono solo un miglioramento incrementale, ma un potenziale cambio di paradigma: un passaggio da sistemi modulari e rigidi a architetture unificate e data-driven capaci di una comprensione più profonda, di una maggiore adattabilità e di una generalizzazione più efficace.

Punto Chiave per il Management: La sfida per raggiungere l'autonomia completa non è più solo una questione di accumulare più chilometri di dati reali. È un problema di generalizzazione. La GenAI offre uno strumento strategico per colmare questa lacuna, consentendo di addestrare i sistemi su una gamma di scenari virtualmente infinita, riducendo i costi e i tempi legati alla raccolta dati su strada.

2. Dati e Benchmark: Il Carburante per l'IA Generativa e la Guida Autonoma

L'affermazione "I dati sono il nuovo petrolio", coniata dall'esperto di dati Clive Humby, è particolarmente calzante per il settore della guida autonoma. La qualità, la diversità e la scala dei dati utilizzati per addestrare e validare i modelli di intelligenza artificiale sono i veri motori del progresso. L'evoluzione dei sistemi autonomi è stata resa possibile non solo da algoritmi più sofisticati, ma anche dalla disponibilità di dataset pubblici su larga scala che fungono da benchmark per l'intera comunità di ricerca e sviluppo. Questi dataset sono la materia prima da cui i modelli generativi imparano a "immaginare" il mondo.

I dataset per la guida autonoma possono essere classificati in diverse categorie, ciascuna con uno scopo specifico. I dataset di percezione da singolo veicolo sono raccolti da un veicolo "ego" equipaggiato con un'ampia suite di sensori (telecamere, LiDAR, radar) e si concentrano su compiti come il rilevamento di oggetti e la comprensione della scena. Tra i più noti vi sono:

● KITTI: Uno dei primi e più influenti, ha fornito dati da telecamere stereo e LiDAR, diventando un punto di riferimento per il rilevamento di oggetti 3D.

● nuScenes: Ha introdotto una visione a 360 gradi con 6 telecamere, LiDAR e radar, insieme a mappe ad alta definizione (HD maps), offrendo una comprensione della scena più completa.

● Waymo Open Dataset: Si distingue per la sua scala e la diversità degli scenari, raccolti in diverse città statunitensi, fornendo dati multimodali di alta qualità.

Una seconda categoria è rappresentata dai dataset multi-agente per la previsione e la pianificazione, che si concentrano non tanto sui dati grezzi dei sensori, quanto sulle traiettorie e sui comportamenti di più utenti della strada (veicoli, pedoni, ciclisti). Questi dataset, come Argoverse e Waymo Open Motion Dataset, sono fondamentali per addestrare modelli in grado di prevedere le interazioni sociali nel traffico, un'area in cui i modelli generativi come i VAE e le GAN sono attivamente applicati per simulare futuri plausibili.

Infine, i dataset sintetici e di simulazione giocano un ruolo cruciale. Creati tramite simulatori come CARLA o motori di videogiochi, questi dataset offerto dati perfettamente annotati e la possibilità di controllare ogni variabile della scena. Il loro valore è inestimabile per la GenAI, in quanto permettono di addestrare modelli su scenari rari o pericolosi (ad esempio, incidenti o condizioni meteorologiche estreme) che sono difficili da catturare nella realtà. L'ultima frontiera è rappresentata dai dataset annotati con linguaggio naturale, come BDD-X e i più recenti NuScenes-QA e DriveLM, che associano i dati visivi a descrizioni testuali, domande e risposte. Questo permette di addestrare modelli linguistici multimodali (MLLM) in grado di ragionare sulla scena di guida e di rispondere a comandi o domande, aprendo la strada a una collaborazione uomo-macchina più intuitiva.

Categoria Dataset | Scopo Principale | Esempi Noti | Ruolo per la GenAI |

Percezione Singolo Veicolo | Rilevamento oggetti, comprensione scena | KITTI, nuScenes, Waymo Open Dataset | Forniscono i dati reali per addestrare modelli a generare immagini e nuvole di punti realistiche. |

Previsione Multi-Agente | Previsione traiettorie, interazioni | Argoverse 1 & 2, Waymo Open Motion | Dati di base per generare comportamenti realistici e socialmente complianti in simulazione. |

Sintetici e Simulazione | Addestramento su casi rari, validazione | CARLA, Virtual KITTI, SHIFT | L'output principale della GenAI, usato per aumentare i dati reali e testare la robustezza. |

Annotati con Linguaggio | Ragionamento sulla scena, VQA | BDD-X, DriveLM, NuScenes-QA | Addestrano modelli multimodali in grado di descrivere, spiegare e rispondere a comandi. |

La sinergia tra dati reali e sintetici è fondamentale: i dati reali migliorano l'accuratezza dei simulatori, mentre i simulatori producono dati sintetici per colmare le lacune dei dataset reali.

3. Modelli a Confronto: Come Funzionano IA Generativa e Guida Autonoma

Per un dirigente d'azienda, comprendere i meccanismi interni dell'Intelligenza Artificiale Generativa non richiede una conoscenza da ingegnere, ma una comprensione dei principi fondamentali e delle diverse "filosofie" che guidano i modelli più diffusi. Ogni approccio ha i suoi punti di forza e le sue debolezze, che lo rendono più o meno adatto a specifici compiti nel contesto della guida autonoma. Possiamo pensare a questi modelli come a diversi tipi di "artisti" o "creatori", ognuno con il suo stile e la sua tecnica.

I Variational Autoencoders (VAE) sono come degli artisti concettuali. Un VAE impara a comprimere un'immagine o un dato in una rappresentazione essenziale e compatta, chiamata spazio latente. Da questo spazio latente, può poi "decodificare" e generare nuove varianti del dato originale. Il suo punto di forza è la capacità di produrre una grande diversità di output. Tuttavia, le immagini generate dai VAE tendono a essere leggermente sfocate, poiché il modello si concentra sull'essenza piuttosto che sui dettagli ad alta frequenza. Nella guida autonoma, sono utili per generare molteplici traiettorie future plausibili per un veicolo, esplorando così diverse possibilità.

Le Generative Adversarial Networks (GAN) funzionano come un duello tra un falsario e un critico d'arte. Una rete neurale, il generatore, cerca di creare dati sintetici (ad esempio, un'immagine di una strada) il più realistici possibile. Un'altra rete, il discriminatore, impara a distinguere i dati reali da quelli falsi creati dal generatore. Le due reti si addestrano a vicenda: il generatore diventa sempre più bravo a ingannare il discriminatore, e il discriminatore diventa sempre più abile a smascherare i falsi. Questo processo "avversariale" porta a risultati di un realismo visivo eccezionale, con dettagli nitidi e texture convincenti. Lo svantaggio è che le GAN possono soffrire di "collasso di modo" (mode collapse), un fenomeno in cui il generatore impara a produrre solo una gamma limitata di output molto realistici, perdendo in diversità.

I Modelli a Diffusione (Diffusion Models) sono come degli scultori che partono da un blocco di marmo grezzo. Il processo inizia con del puro rumore (un'immagine statica, senza senso) e, passo dopo passo, un modello neurale "denoiser" rimuove gradualmente il rumore, facendo emergere un'immagine coerente e dettagliata. Questo approccio iterativo ha raggiunto risultati allo stato dell'arte in termini di qualità e diversità delle immagini generate, superando spesso le GAN e riducendo il rischio di collasso di modo. La loro principale debolezza è la lentezza del processo di generazione, che richiede centinaia o migliaia di passaggi, rendendoli computazionalmente più costosi rispetto a VAE e GAN.

Infine, esistono modelli specializzati per la rappresentazione 3D. I Neural Radiance Fields (NeRF) e i 3D Gaussian Splatting (3DGS) sono tecniche che imparano a rappresentare una scena tridimensionale completa partendo da un insieme di immagini 2D. Un NeRF impara una funzione continua che descrive il colore e la densità di ogni punto nello spazio, mentre un 3DGS rappresenta la scena come una collezione di primitive gaussiane 3D. Entrambi sono fondamentali per creare gemelli digitali fotorealistici e navigabili, essenziali per la simulazione. I 3DGS, in particolare, si distinguono per la loro capacità di rendering in tempo reale.

Consiglio Pratico: Non esiste un modello "migliore" in assoluto. La scelta dipende dall'obiettivo:

● Per la diversità e l'esplorazione di possibilità (es. traiettorie): i VAE sono un buon punto di partenza.

● Per il massimo realismo visivo (es. immagini per la percezione): le GAN e i Modelli a Diffusione sono i leader.

● Per creare ambienti di simulazione 3D fotorealistici: i NeRF e i 3DGS sono le tecnologie di riferimento.

4. Creare Scenari Realistici: Generazione di Immagini per l'IA Generativa e la Guida Autonoma

La generazione di immagini sintetiche per la guida autonoma non è un semplice esercizio artistico; è una necessità strategica. L'obiettivo non è solo creare immagini fotorealistiche, ma anche fisicamente plausibili e controllabili. Un sistema autonomo deve essere addestrato su dati che rispettino le leggi della fisica e la logica del mondo reale. Per questo, gli algoritmi di generazione di immagini devono incorporare meccanismi di controllo precisi, permettendo agli ingegneri di definire in dettaglio gli scenari da creare. Le metodologie attuali si concentrano principalmente su due approcci complementari: la generazione controllabile e la generazione decomposizionale.

La generazione controllabile utilizza informazioni contestuali di vario tipo per guidare il processo di sintesi. Uno degli input di controllo più efficaci è la mappa in vista a volo d'uccello (Bird's-Eye View o BEV). Metodi come BEVGen e MagicDrive utilizzano layout BEV, che definiscono la geometria della strada e la posizione degli oggetti, per generare immagini coerenti da più punti di vista. Questo garantisce che la scena 3D implicita sia corretta e che le relazioni spaziali tra gli oggetti siano mantenute. Ad esempio, si può fornire al modello una mappa BEV con una specifica configurazione di veicoli a un incrocio e il modello genererà le corrispondenti viste dalle telecamere del veicolo ego, rispettando la prospettiva e le occlusioni.

Oltre ai layout geometrici, le descrizioni testuali sono un altro potente strumento di controllo. L'integrazione di encoder di testo permette di guidare la generazione con prompt come "scena notturna con pioggia battente" o "strada urbana affollata in una giornata di sole". Modelli come WeatherDG e ChatSim sfruttano i modelli linguistici di grandi dimensioni (LLM) per interpretare queste descrizioni e tradurle in attributi visivi specifici, arricchindo l'ambiente con dettagli contestuali. Questo permette di creare sistematicamente dati per scenari di "coda lunga" legati a condizioni ambientali avverse, che sono difficili e costosi da raccogliere nel mondo reale.

Il secondo approccio, la generazione decomposizionale, affronta la complessità delle scene urbane scomponendole in elementi separati. Invece di generare l'intera immagine in un unico passaggio, questi metodi distinguono tra lo sfondo statico (strade, edifici, vegetazione) e gli agenti dinamici (veicoli, pedoni). Panoptic Neural Fields e Block-NeRF sono esempi di questa filosofia. Block-NeRF, ad esempio, suddivide una grande scena urbana in blocchi gestibili, che possono essere generati e combinati in modo composizionale per creare interi paesaggi urbani. Questo approccio non solo rende il processo più scalabile, ma facilita anche la modifica mirata della scena. Ad esempio, è possibile mantenere lo stesso sfondo stradale e generare diverse configurazioni di traffico, o viceversa, testando lo stesso scenario di traffico in diversi contesti urbani. Piattaforme di simulazione come UniSim e CADSim sfruttano questa logica per consentire l'aggiornamento indipendente di specifici elementi della scena senza dover rigenerare l'intero ambiente, promuovendo l'adattabilità in tempo reale. Questa capacità di "editing" granulare è fondamentale per creare test di validazione mirati e per analizzare la robustezza dei sistemi di percezione in modo sistematico.

5. Visione 3D e LiDAR: Un Pilastro dell'IA Generativa e Guida Autonoma

Se le telecamere forniscono una visione ricca e a colori del mondo, il LiDAR (Light Detection and Ranging) ne fornisce la struttura tridimensionale precisa. Questo sensore è indispensabile per compiti come il rilevamento di oggetti 3D, la mappatura e la localizzazione. Tuttavia, la generazione di dati LiDAR sintetici presenta sfide uniche. A differenza delle immagini, le nuvole di punti LiDAR sono sparse, non uniformi e influenzate da fenomeni fisici complessi come l'assorbimento del materiale, i riflessi e il "raydrop" (raggi che non ritornano al sensore). Creare dati sintetici che replichino fedelmente queste caratteristiche è cruciale per addestrare e validare i sistemi di percezione basati su LiDAR.

I primi approcci alla generazione LiDAR si basavano principalmente sulla simulazione fisica, utilizzando il ray-casting in motori grafici per approssimare il comportamento di un sensore reale. Piattaforme come LiDARsim hanno migliorato questo approccio integrando modelli di deep learning per simulare effetti come il raydrop, riducendo così il divario tra dati simulati e reali. Tuttavia, questi metodi, pur essendo interpretabili, dipendono da modelli di sensori predefiniti e faticano ad adattarsi a nuove configurazioni hardware o a fenomeni fisici non modellati esplicitamente.

La vera svolta è arrivata con l'applicazione di modelli generativi avanzati. I modelli a diffusione si sono rivelati particolarmente efficaci. LiDMs e RangeLDM utilizzano un framework di diffusione latente per generare nuvole di punti ad alta fedeltà, preservando i dettagli strutturali e geometrici. Questi modelli possono essere utilizzati non solo per generare intere scene da zero, ma anche per compiti di "upsampling" (aumentare la densità di una nuvola di punti) e "inpainting" (completare parti mancanti o occluse). L'evoluzione successiva, rappresentata da LidarDM, estende la generazione allo spazio-tempo (4D), simulando sequenze di nuvole di punti temporalmente coerenti che tengono conto del movimento degli agenti. Per la prima volta, è diventato possibile generare dati LiDAR per scenari dinamici complessi, un passo fondamentale per la simulazione.

Un'altra frontiera è la generazione multimodale e controllabile. GenMM è un framework a diffusione che può modificare congiuntamente video RGB e dati LiDAR, garantendo che le modifiche apportate in una modalità (ad esempio, la rimozione di un veicolo dal video) si riflettano coerentemente nell'altra (la rimozione della corrispondente nuvola di punti). L'approccio più innovativo è forse quello di Text2LiDAR, che introduce la generazione di nuvole di punti guidata da descrizioni testuali. Utilizzando un'architettura basata su Transformer, questo modello può generare scene LiDAR dettagliate a partire da prompt come "una strada urbana con un'auto parcheggiata sulla destra e un ciclista che si avvicina". Questa capacità di controllo semantico apre possibilità senza precedenti per la creazione di dataset su misura per testare scenari specifici.

I Neural Radiance Fields (NeRF) offrono un approccio alternativo, modellando la scena in modo continuo e implicito. NeRF-LiDAR e DyNFL utilizzano rappresentazioni neurali per simulare il modo in cui i raggi LiDAR interagiscono con l'ambiente, generando dati che rispettano la geometria e la fisica della scena. Questi metodi sono particolarmente adatti per la re-simulazione di scene dinamiche e per l'editing, poiché permettono di modificare separatamente lo sfondo statico e gli oggetti in movimento.

Esempio Operativo: Immaginate di dover testare la reazione del vostro sistema autonomo a un pedone che sbuca improvvisamente da dietro un autobus. Raccogliere dati reali per questo scenario è pericoloso e inefficiente. Utilizzando un modello come Text2LiDAR, un ingegnere può semplicemente descrivere la scena con un prompt di testo e generare centinaia di varianti della nuvola di punti LiDAR, cambiando la posizione del pedone, la sua velocità o il tipo di veicolo che lo occulta. Questo accelera drasticamente il ciclo di validazione.

6. Previsione di Traiettorie: Anticipare il Futuro con IA Generativa e Guida Autonoma

Prevedere accuratamente il movimento futuro degli altri utenti della strada è una delle funzioni più critiche e complesse per un veicolo autonomo. La pianificazione del moto tradizionale spesso cerca un'unica traiettoria "ottimale" basata su criteri di sicurezza e comfort, un approccio che si rivela inadeguato in ambienti urbani densi e altamente interattivi. La realtà del traffico è intrinsecamente multimodale e incerta: un veicolo a un incrocio potrebbe svoltare a destra, a sinistra o proseguire dritto. Un approccio deterministico che considera solo l'opzione più probabile è fragile. I modelli generativi offrono un cambio di prospettiva: invece di prevedere una singola traiettoria, imparano a campionare da una distribuzione di futuri plausibili, gestendo in modo nativo l'incertezza e le interazioni sociali.

I primi lavori in questo campo hanno sfruttato i VAE (Variational Autoencoders) e le GAN (Generative Adversarial Networks). I VAE, grazie alla loro capacità di modellare una distribuzione latente, sono eccellenti per generare una gamma diversificata di traiettorie future. Lavori influenti come DESIRE e Trajectron++ hanno utilizzato architetture basate su CVAE (Conditional VAE) per prevedere i percorsi di più agenti contemporaneamente, tenendo conto delle loro interazioni attraverso strutture a grafo e delle geometrie stradali fornite dalle mappe HD. Questi modelli sono in grado di generare un "ventaglio" di possibili futuri, permettendo al veicolo ego di pianificare una manovra che sia sicura rispetto a tutte le eventualità più probabili. Le GAN, d'altra parte, si sono concentrate sulla generazione di traiettorie altamente realistiche e socialmente accettabili. Modelli come Social GAN hanno introdotto meccanismi per aggregare il contesto sociale e generare percorsi che un discriminatore fatica a distinguere da quelli umani reali.

Più di recente, i modelli a diffusione si sono affermati come lo stato dell'arte anche in questo ambito, grazie alla loro capacità di generare campioni di alta qualità e a un addestramento più stabile. Funzionano imparando a invertire un processo che aggiunge gradualmente rumore a traiettorie reali. In fase di inferenza, partono da rumore casuale e lo "denoisano" passo dopo passo fino a ottenere una traiettoria strutturata e coerente, condizionata dal contesto della scena (storia passata, mappa, posizione di altri agenti).

MotionDiffuser è un esempio chiave che utilizza un Transformer invariante alla permutazione per generare traiettorie congiunte per più agenti, garantendo che siano prive di collisioni e socialmente coerenti. La vera potenza di questi modelli risiede nella loro flessibilità: possono integrare facilmente vincoli ambientali e fisici, e lavori come Diffusion-Planner hanno dimostrato di poter unificare la previsione multi-agente e la pianificazione del veicolo ego in un unico framework, consentendo una guida consapevole delle interazioni senza regole definite manualmente.

L'ultima frontiera è rappresentata dai modelli sequenziali basati su Transformer e MLLM (Multimodal Large Language Models). Questi approcci trattano le traiettorie come sequenze di stati o azioni, in modo simile a come un LLM tratta una frase come una sequenza di parole. Modelli come BehaviorGPT utilizzano la previsione autoregressiva per simulare il traffico con alta fedeltà. L'integrazione di MLLM, come in GPT-Driver o EMMA di Waymo, apre la possibilità di incorporare una comprensione del mondo più ampia e capacità di ragionamento. Questi modelli possono mappare direttamente i dati grezzi dei sensori e le istruzioni in linguaggio naturale in azioni di guida, utilizzando il ragionamento "chain-of-thought" per spiegare le loro decisioni. Sebbene ancora in una fase relativamente nascente per la previsione multi-agente complessa, questo approccio promette di gestire scenari intricati e di integrare diverse modalità di dati in un modo che i modelli precedenti non potevano fare.

7. Navigazione Sicura: Occupancy Grid nell'IA Generativa e Guida Autonoma

Oltre a riconoscere singoli oggetti, un veicolo autonomo deve avere una comprensione olistica dello spazio che lo circonda, inclusi gli ostacoli generici e le aree libere in cui può navigare in sicurezza. La griglia di occupazione (occupancy grid) è una rappresentazione 3D che affronta proprio questa esigenza. Si tratta di una griglia voxelizzata dello spazio attorno al veicolo, in cui ogni cella (voxel) è etichettata come "occupata", "libera" o "sconosciuta". Questo tipo di rappresentazione è potente perché è agnostica rispetto alla classe degli oggetti: un muro, un cespuglio o un veicolo non classificato sono tutti trattati semplicemente come spazio occupato, garantendo un livello di sicurezza di base.

Una delle sfide uniche di questo settore è la mancanza di dati di ground truth. I dataset standard come nuScenes o Waymo non forniscono etichette di occupazione 3D. Di conseguenza, i ricercatori hanno dovuto sviluppare metodi per generare queste annotazioni in modo semi-automatico, tipicamente fondendo più scansioni LiDAR nel tempo per creare una mappa densa della scena. Lavori fondamentali come Occ3D hanno creato benchmark su larga scala che sono diventati la base per addestrare i modelli successivi. Altri approcci, come SurroundOcc, si sono concentrati sul migliorare la densità delle griglie fusionando dati LiDAR e telecamere ad alta risoluzione per riempire le aree occluse.

Una volta ottenuti i dati di addestramento, la ricerca si è focalizzata su due compiti principali: la previsione di occupazione futura e la generazione di scene di occupazione. La previsione di occupazione, come quella realizzata da OccWorld, utilizza modelli generativi per prevedere come la griglia di occupazione evolverà nei prossimi secondi. Questo è fondamentale per la pianificazione a lungo termine, poiché permette al veicolo di anticipare non solo il movimento di oggetti noti, ma anche l'evoluzione generale della scena.

La generazione di scene di occupazione, invece, si concentra sulla creazione di intere griglie 3D da zero, spesso condizionate da altri input. UrbanDiffusion, ad esempio, utilizza un modello a diffusione per generare griglie di occupazione 3D statiche a partire da mappe BEV. Questo permette di creare ambienti 3D strutturati e semanticamente coerenti. L'evoluzione di questo approccio, rappresentata da modelli come OccSora e DOME, estende la generazione a scene dinamiche (4D), condizionandola alle traiettorie del veicolo ego. Questi modelli possono simulare l'evoluzione temporale della scena su più frame, un passo cruciale verso la creazione di simulatori di mondo completi. L'approccio più avanzato è quello di OccLLaMA, che integra in modo unico le modalità di visione, linguaggio e azione. Utilizza un VQ-VAE per "tokenizzare" l'occupazione storica, il movimento del veicolo ego e le descrizioni linguistiche, e addestra un LLaMA pre-addestrato per prevedere i token futuri per tutte e tre le modalità. Il risultato è un modello mondiale multimodale in grado non solo di generare l'occupazione futura, ma anche di pianificare il movimento e rispondere a domande sulla scena.

La complessità di questi modelli e l'assenza di dati di ground truth diretti rendono la loro implementazione strategica una sfida significativa per le aziende. Comprendere quale approccio di generazione di occupazione sia più adatto a un determinato caso d'uso, come validarne l'output e come integrarlo efficacemente nello stack di guida richiede competenze specialistiche. È in questa fase che partner consulenziali come Rhythm Blues AI possono fornire un valore decisivo. Attraverso un audit iniziale, è possibile mappare i processi esistenti e identificare dove modelli avanzati come quelli per la generazione di occupazione possono offrire il massimo ritorno sull'investimento, definendo un percorso strategico per la loro adozione.

8. Applicazioni Strategiche: Gemelli Digitali nell'IA Generativa e Guida Autonoma

L'impatto dell'Intelligenza Artificiale Generativa sulla guida autonoma non è più solo teorico. Sta già alimentando una serie di applicazioni pratiche che stanno accelerando lo sviluppo, migliorando la sicurezza e riducendo i costi. Queste applicazioni trasformano i modelli generativi da semplici strumenti di ricerca a veri e propri asset strategici per le aziende del settore.

L'applicazione più immediata e diffusa è la generazione di dati sintetici per l'addestramento e la validazione. Come già accennato, la GenAI permette di creare dati per i sensori (immagini, video, LiDAR) in modo controllato e su larga scala. Questo è fondamentale per arricchire i dataset di addestramento con scenari di "coda lunga". Ad esempio, modelli come Panacea e DriveScape possono generare video di guida realistici in condizioni meteorologiche avverse, mentre RangeLDM può creare nuvole di punti LiDAR per scenari con configurazioni di oggetti rare. Questo non solo migliora la robustezza dei modelli di percezione, ma riduce drasticamente la necessità di costose e lunghe campagne di raccolta dati su strada.

Un'evoluzione di questo concetto è la creazione di Gemelli Digitali (Digital Twins). Un gemello digitale è una replica virtuale ad alta fedeltà di un ambiente fisico, che permette test scalabili, controllabili e riproducibili. La GenAI è il motore che alimenta questi gemelli. Attraverso il processo Real2Sim, i dati del mondo reale (scansioni LiDAR, immagini satellitari, mappe HD) vengono utilizzati per ricostruire un ambiente virtuale. Modelli come Block-NeRF e OmniRe eccellono in questo, creando ambienti 3D/4D fotorealistici e navigabili. Un esempio concreto è il gemello digitale del Mcity Test Facility, una vera area di prova di 32 acri che è stata replicata in simulazione. Gli ingegneri possono "guidare" per milioni di chilometri in questa replica virtuale, testando scenari che sarebbero impossibili o troppo pericolosi da replicare costantemente nel mondo fisico, per poi validare gli stessi scenari sulla pista reale.

Il passo successivo è la simulazione a ciclo chiuso (closed-loop). A differenza del semplice replay di dati registrati, in una simulazione a ciclo chiuso le azioni del veicolo autonomo influenzano l'ambiente e gli altri agenti, che a loro volta reagiscono. Piattaforme come DriveArena utilizzano modelli di agenti generativi che rispondono in tempo reale alle manovre del veicolo ego, invece di seguire uno script predefinito. Questo permette di testare scenari controfattuali ("Cosa succederebbe se il nostro veicolo frenasse bruscamente? Come reagirebbero gli altri?") e di addestrare politiche di guida tramite reinforcement learning in un ambiente interattivo e realistico.

Infine, la GenAI sta abilitando una nuova generazione di sistemi di guida end-to-end. Invece di una pipeline modulare (percezione, previsione, pianificazione), un modello end-to-end impara a mappare direttamente l'input dei sensori alle azioni di controllo. Modelli generativi come GenAD e DiffusionDrive affrontano questo compito come un problema di generazione di traiettorie. L'integrazione di MLLM, come in LMDrive ed EMMA, porta questi sistemi a un livello superiore, consentendo loro di interpretare comandi in linguaggio naturale e di ragionare su scenari complessi, unificando percezione, pianificazione e controllo in un unico framework. Sebbene la validazione di questi sistemi complessi rimanga una sfida aperta, essi rappresentano la frontiera più avanzata della ricerca.

9. Sfide Tecniche: Affidabilità e Scalabilità di IA Generativa e Guida Autonoma

Nonostante i notevoli progressi, la transizione verso una guida autonoma di Livello 5 pienamente affidabile è ancora costellata di sfide tecniche fondamentali. L'Intelligenza Artificiale Generativa offre strumenti potenti per affrontare alcuni di questi ostacoli, ma introduce anche nuove complessità. Per i leader aziendali, comprendere questi limiti è tanto importante quanto riconoscere le opportunità, poiché una valutazione realistica è alla base di qualsiasi strategia di investimento e sviluppo di successo. I tre principali ostacoli tecnici che l'industria sta affrontando sono la generalizzazione, l'affidabilità e la scalabilità.

Il primo e più critico problema è la generalizzazione, strettamente legato alla già citata sfida della "coda lunga". I sistemi di guida autonoma devono operare in modo sicuro e prevedibile in un mondo aperto e imprevedibile. Anche i modelli più sofisticati possono fallire quando si trovano di fronte a situazioni che si discostano in modo significativo dai dati su cui sono stati addestrati. La GenAI affronta questo problema generando dati sintetici per diversificare l'addestramento, ma la domanda rimane: come possiamo essere sicuri che i dati generati coprano tutte le possibili varianti critiche? E come possiamo validare che un modello addestrato su dati parzialmente sintetici si comporterà correttamente nel mondo reale? La ricerca si sta muovendo verso la generazione di scenari avversari, in cui un'altra IA cerca attivamente di trovare i punti deboli del sistema di guida, e verso quadri di validazione che combinano simulazione, test su pista e test su strada pubblica in modo strutturato.

Il secondo ostacolo è garantire l'affidabilità e la gestione dell'incertezza. I modelli di IA, in particolare quelli generativi, non sono deterministici come il software tradizionale. Possono "allucinare", ovvero produrre output plausibili ma fattualmente errati. In un contesto di guida, un'allucinazione potrebbe essere catastrofica. Per questo, la ricerca si sta concentrando sulla quantificazione dell'incertezza. Un sistema affidabile non dovrebbe solo fare una previsione, ma anche comunicare il suo grado di fiducia in quella previsione. Tecniche come i deep ensembles e le reti neurali evidenziali vengono applicate ai generatori di traiettorie in modo che un veicolo possa riconoscere quando una situazione è fuori dalla sua "comfort zone" e, se necessario, passare a una modalità di guida più conservativa o richiedere l'intervento umano (o di un supervisore remoto). La fiducia nei modelli generativi richiede anche trasparenza e interpretabilità, in modo che gli ingegneri possano capire perché un modello ha preso una certa decisione, specialmente in caso di fallimento.

Il terzo problema è la complessità e la scalabilità dei sistemi. I modelli generativi, specialmente quelli a diffusione e i grandi modelli multimodali, sono computazionalmente molto esigenti. L'hardware di bordo di un veicolo ha vincoli di costo, consumo energetico e dissipazione del calore molto più stringenti rispetto a un data center. Distillare la conoscenza di questi modelli di grandi dimensioni in reti più piccole ed efficienti che possano funzionare in tempo reale su hardware automobilistico è una sfida ingegneristica significativa. Inoltre, la scalabilità economica è un fattore critico. I costi associati a suite di sensori complessi, come i LiDAR ad alta risoluzione, e alla potenza di calcolo necessaria per eseguire questi modelli, possono ostacolare un'ampia adozione della tecnologia. La ricerca sta esplorando architetture più efficienti e l'ottimizzazione dell'hardware, ma il compromesso tra prestazioni, costo e affidabilità rimane un equilibrio delicato da gestire. Per le aziende, questo significa che la strategia di adozione deve essere graduale, partendo da casi d'uso in cui il valore aggiunto giustifica la complessità e il costo, per poi scalare man mano che la tecnologia matura e i costi diminuiscono.

10. Impatto Etico e Sociale: Il Futuro dell'IA Generativa e Guida Autonoma

L'integrazione dell'Intelligenza Artificiale Generativa nei veicoli autonomi non è solo una sfida tecnica, ma solleva anche profonde questioni etiche, legali e sociali che richiedono un'attenta considerazione. La fiducia del pubblico, un quadro di responsabilità chiaro e una gestione equa dell'impatto economico sono pilastri fondamentali per una transizione di successo verso la mobilità autonoma. Ignorare queste dimensioni significa rischiare un rigetto da parte della società, indipendentemente dalla perfezione tecnologica.

La questione etica più nota è il "problema del carrello" (trolley problem), che riguarda le decisioni in scenari di incidente inevitabile. Se un veicolo autonomo deve scegliere tra due esiti negativi, quali principi morali dovrebbe seguire? I modelli generativi complicano ulteriormente la questione, poiché le loro decisioni emergono da dati e processi di addestramento complessi, non da regole esplicite. Un modello potrebbe sviluppare bias impliciti basati sulla frequenza degli scenari nei dati di addestramento, portando a decisioni che potrebbero essere percepite come discriminatorie. Paesi come la Germania hanno già stabilito linee guida che vietano decisioni basate su fattori come età o genere delle potenziali vittime, ma tradurre questi principi etici in codice e modelli neurali è una sfida aperta. La ricerca sulla value alignment mira a garantire che gli obiettivi di un'IA siano allineati con i valori umani, un campo di studio cruciale per la sicurezza dell'IA in generale.

Strettamente legata all'etica è la questione della responsabilità legale e normativa. Se un'IA generativa causa un incidente, chi è responsabile: il produttore del veicolo, lo sviluppatore del software, il proprietario del veicolo o l'ente che ha fornito i dati di addestramento? Le leggi attuali, basate su conducenti umani, non sono adeguate. C'è un urgente bisogno di riforme legali che stabiliscano quadri di responsabilità chiari. Normative come l'AI Act europeo stanno iniziando ad affrontare questo problema, classificando l'IA nella mobilità come ad alto rischio e richiedendo trasparenza sui dati di addestramento e valutazioni dei bias. La fiducia del pubblico è un altro fattore critico, e attualmente è bassa. Recenti sondaggi indicano che una maggioranza di persone ha paura dei veicoli autonomi, e incidenti isolati, anche di vandalismo contro i robotaxi come quelli subiti da Waymo, vengono amplificati dai media, minando la fiducia. Costruire questa fiducia richiede una trasparenza radicale, una comunicazione chiara sulle capacità e i limiti della tecnologia, e una comprovata sicurezza attraverso test rigorosi.

Infine, l'impatto economico e sociale non può essere sottovalutato. L'automazione della guida minaccia di sostituire milioni di posti di lavoro nel settore dei trasporti, come camionisti, tassisti e autisti di consegne. Questa transizione potrebbe avvenire più velocemente di quanto l'economia possa riqualificare e riassorbire la forza lavoro, creando tensioni sociali e politiche. Sono necessarie politiche proattive, come programmi di formazione e un'introduzione graduale della tecnologia, per gestire questa trasformazione. Inoltre, esiste il rischio di acuire le disuguaglianze economiche. L'accesso ai veicoli autonomi potrebbe inizialmente essere un lusso, e le aree rurali o a basso reddito potrebbero essere servite per ultime, ampliando il divario di mobilità. Garantire un accesso equo, ad esempio attraverso flotte di trasporto pubblico autonomo sovvenzionate, sarà essenziale per assicurare che i benefici di questa tecnologia siano condivisi da tutta la società.

Conclusioni: Una Prospettiva Strategica per Imprenditori e Manager

L'analisi della convergenza tra IA Generativa e Guida Autonoma rivela un quadro complesso, ricco di potenziale ma anche di sfide inedite. Per un leader aziendale, la conclusione non può essere un semplice riassunto dei progressi tecnologici, ma una riflessione strategica sulle implicazioni profonde di questo cambiamento. Non stiamo assistendo a un'evoluzione lineare dei sistemi ADAS, ma a un potenziale cambio di paradigma che richiede un nuovo modo di pensare l'innovazione, il rischio e il valore.

Le tecnologie attuali, come quelle di fornitori consolidati quali Mobileye, si basano su un approccio modulare, robusto e ampiamente validato. Ogni funzione (frenata d'emergenza, mantenimento di corsia) è un componente discreto, ingegnerizzato per un compito specifico. Questo approccio ha il vantaggio della prevedibilità e della certificabilità, ma mostra i suoi limiti di fronte alla complessità del mondo reale, in particolare nel risolvere il problema della "coda lunga".

La GenAI, con il suo approccio end-to-end e la sua capacità di "immaginare" scenari, offre una via per superare questa barriera. Modelli come quelli di Waymo e di altre aziende all'avanguardia non si limitano a eseguire regole, ma imparano una rappresentazione olistica del mondo. Questo sposta il problema dall'ingegneria del software tradizionale alla gestione di sistemi di apprendimento probabilistici. La vera sfida non è più solo scrivere codice corretto, ma curare dataset, validare l'output di un modello che può essere intrinsecamente non deterministico e garantire che il suo comportamento generalizzi in modo sicuro.

Per un imprenditore o un manager, questo significa tre cose:

1. Le Competenze Devono Cambiare: Le aziende avranno bisogno non solo di ingegneri software, ma anche di data scientist, esperti di etica dell'IA e specialisti di governance dei modelli. La capacità di gestire e validare dati e modelli diventerà una competenza chiave tanto quanto la meccatronica.

2. Il Rischio Va Ridefinito: Il rischio non è più solo legato al malfunzionamento di un componente hardware o software, ma anche al comportamento emergente e non previsto di un modello di IA. La gestione del rischio deve includere il monitoraggio continuo dei modelli, la rilevazione di "allucinazioni" e la definizione di protocolli di sicurezza che possano supervisionare e, se necessario, correggere le decisioni dell'IA.

3. L'Investimento è Strategico, non solo Tecnologico: Adottare la GenAI non significa semplicemente acquistare una nuova tecnologia, ma investire in un nuovo modo di operare. Richiede una visione a lungo termine, la volontà di sperimentare in ambienti controllati (come i gemelli digitali) e la capacità di costruire fiducia sia all'interno dell'organizzazione che con il pubblico e i regolatori.

In conclusione, l'era della GenAI nella guida autonoma non promette soluzioni facili. Al contrario, introduce un livello di complessità più elevato. Tuttavia, è proprio gestendo questa complessità che le aziende potranno sbloccare un livello di autonomia e affidabilità irraggiungibile con gli approcci tradizionali, trasformando una sfida ingegneristica in un vantaggio competitivo duraturo. La domanda per i leader non è "se" adottare queste tecnologie, ma "come" costruire l'organizzazione, la cultura e la strategia per farlo in modo responsabile ed efficace.

Domande Frequenti (FAQ)

1. Cos'è l'Intelligenza Artificiale Generativa (GenAI) nel contesto della guida autonoma?

L'IA Generativa è una branca dell'intelligenza artificiale che, invece di limitarsi a classificare o prevedere dati, è in grado di creare nuovi contenuti sintetici, come immagini, video, nuvole di punti LiDAR o traiettorie di guida. Nella guida autonoma, viene usata principalmente per generare scenari di traffico realistici e diversificati per addestrare e testare i veicoli in modo più completo.

2. Qual è il problema della "coda lunga" (long tail) e come la GenAI aiuta a risolverlo?

Il problema della "coda lunga" si riferisce all'infinita varietà di eventi rari ma critici (es. condizioni meteo estreme, comportamenti imprevedibili di pedoni) che un veicolo autonomo può incontrare. Raccogliere dati reali per tutti questi eventi è impossibile. La GenAI aiuta generando sinteticamente questi scenari rari in grandi quantità, permettendo ai sistemi di "allenarsi" per situazioni che non hanno mai visto nel mondo reale.

3. Quali sono le principali differenze tra i modelli generativi come GAN, VAE e Modelli a Diffusione?

● VAE (Variational Autoencoders): Ottimi per generare grande diversità di output, ma a volte a scapito della nitidezza dei dettagli.

● GAN (Generative Adversarial Networks): Producono risultati molto realistici e nitidi grazie a un processo "competitivo" tra due reti, ma possono mancare di diversità.

● Modelli a Diffusione: Offrono un eccellente equilibrio tra qualità e diversità, ma sono computazionalmente più lenti e costosi da eseguire.

4. Cosa sono i "Gemelli Digitali" (Digital Twins) per la guida autonoma?

Un gemello digitale è una replica virtuale, interattiva e ad alta fedeltà di un ambiente fisico, come una città o un'area di prova. La GenAI è usata per costruire e popolare questi mondi virtuali, permettendo di testare i veicoli autonomi in simulazioni realistiche per milioni di chilometri prima di metterli su strada.

5. La GenAI può rendere i veicoli autonomi completamente sicuri?

La GenAI è uno strumento potente per migliorare la sicurezza, in particolare la capacità di un veicolo di gestire eventi imprevisti. Tuttavia, introduce anche nuove sfide, come la necessità di validare i modelli e prevenire "allucinazioni". La sicurezza totale non può essere garantita solo dalla GenAI, ma richiede un approccio integrato con sistemi di monitoraggio, regole di sicurezza rigide e una rigorosa validazione.

6. Cosa si intende per guida autonoma "end-to-end"?

È un approccio in cui un singolo modello di IA apprende a mappare direttamente gli input dei sensori (es. immagini delle telecamere) alle azioni di guida (es. sterzare, accelerare), senza passare per moduli intermedi separati come percezione, previsione e pianificazione. La GenAI è una tecnologia chiave per sviluppare questi sistemi complessi.

7. Quali sono le principali sfide etiche legate all'uso dell'IA nella guida autonoma?

Le sfide principali includono la gestione delle decisioni in scenari di incidente inevitabile (il "problema del carrello"), la garanzia che i modelli non abbiano pregiudizi (bias) derivanti dai dati di addestramento, e la definizione di chi sia legalmente responsabile in caso di incidente causato dall'IA.

8. L'attuale legislazione è pronta per i veicoli autonomi basati su GenAI?

No, la maggior parte delle legislazioni attuali è ancora basata sulla presenza di un conducente umano. C'è un grande lavoro in corso a livello globale per sviluppare nuovi quadri normativi, come l'AI Act in Europa, che affrontino le questioni di responsabilità, certificazione e sicurezza per i sistemi basati sull'IA.

9. Quale sarà l'impatto economico della guida autonoma sul mercato del lavoro?

Si prevede un impatto significativo, con la potenziale automazione di milioni di posti di lavoro legati alla guida (camionisti, tassisti, etc.). Questo richiederà politiche proattive per la riqualificazione della forza lavoro e la gestione della transizione verso nuove professioni, come la gestione di flotte autonome o la supervisione remota dei veicoli.

10. Come può un'azienda iniziare a integrare la GenAI nelle proprie soluzioni di mobilità?

Un approccio strategico prevede un'analisi iniziale (audit) per identificare i casi d'uso a più alto valore, come la generazione di dati per la validazione o la simulazione di scenari specifici. È consigliabile iniziare con progetti pilota in ambienti controllati e scalare gradualmente, avvalendosi di partner con competenze specifiche per navigare la complessità tecnologica e strategica.

Vuoi approfondire?

Se la tua azienda sta esplorando il potenziale dell'Intelligenza Artificiale e desideri capire come applicarla in modo strategico e sostenibile, puoi fissare una consulenza iniziale gratuita di 30 minuti con Rhythm Blues AI. Sarà un'occasione per analizzare le tue esigenze specifiche e costruire un piano d'azione personalizzato.

Commenti