Strategie Aziendali IA 2025: La Guida Completa per Manager dal Rapporto Aspen Institute

- Andrea Viliotti

- 5 ago 2025

- Tempo di lettura: 21 min

L'intelligenza artificiale è ormai una leva strategica in una competizione globale che vede Stati Uniti, Cina ed Europa impegnati in massicci investimenti. Dal progetto "Stargate" da 500 miliardi di dollari al piano InvestAI europeo, la corsa all'IA ridefinisce i paradigmi industriali e geopolitici. Questo articolo, basato sulle analisi del Rapporto Intelligenza Artificiale 2025 dell'Aspen Institute Italia, esplora le tendenze di adozione, gli avanzamenti tecnici, le sfide etiche e normative, e l'impatto sul mondo del lavoro, offrendo una bussola per imprenditori e dirigenti che vogliono navigare la complessità di questa trasformazione e tradurla in un vantaggio competitivo concreto.

1. La Corsa Globale all'IA: Mappare le Strategie Aziendali IA dei Leader Mondiali

L'intelligenza artificiale ha smesso da tempo di essere un semplice argomento tecnico per diventare il fulcro di una competizione strategica globale. Le principali potenze mondiali stanno delineando approcci distinti, specchio delle loro priorità economiche e politiche. Gli Stati Uniti continuano a puntare su un modello guidato dal settore privato, come dimostra l'annuncio del progetto "Stargate", una joint venture tra colossi come OpenAI, Oracle e SoftBank con investimenti previsti fino a cinquecento miliardi di dollari per lo sviluppo di infrastrutture dedicate. Questo approccio, focalizzato sull'accelerazione tramite grandi consorzi privati, si contrappone nettamente al modello cinese. La Cina, infatti, persegue una strategia di centralizzazione statale, con l'obiettivo dichiarato di raggiungere l'autosufficienza e il primato tecnologico globale entro il 2030, orchestrando investimenti pubblici e allineando le grandi aziende tecnologiche nazionali (come Baidu, Alibaba e Tencent) a un'agenda governativa.

In questo scenario, l'Unione Europea cerca di tracciare una "terza via". Dopo essersi concentrata a lungo sul fronte regolatorio, culminato con l'adozione dell'AI Act, ora sta intensificando gli sforzi per sostenere il proprio tessuto industriale. L'iniziativa InvestAI, che mira a mobilitare duecento miliardi di euro, è il segnale più forte di questa nuova fase, volta a creare un'IA affidabile e competitiva, fondata su etica, sicurezza e tutela dei diritti.

Nonostante l'enorme flusso di capitali, l'impatto economico immediato dell'IA solleva ancora interrogativi. L'economista Daron Acemoğlu del MIT, ad esempio, invita alla cautela, stimando che nel prossimo decennio l'intelligenza artificiale potrebbe contribuire a un aumento del PIL statunitense inferiore all'1,6%, con un incremento della produttività annua modesto. Questa visione non nega il potenziale dell'IA come tecnologia "general purpose", capace di trasformare il rapporto tra capitale e lavoro, ma suggerisce che i benefici economici tangibili richiederanno tempo e, soprattutto, un'integrazione intelligente e strategica nei sistemi economici esistenti. L'IA non è una bacchetta magica, ma una leva strategica il cui valore dipenderà dalla capacità di governi e imprese di governarne la complessità.

2. La Catena del Valore dell'IA: Come le Strategie Aziendali IA Dipendono da Hardware e Dati

Per comprendere appieno le dinamiche competitive e geopolitiche che circondano l'intelligenza artificiale, è essenziale analizzare la sua catena del valore. Un modello concettuale utile scompone l'ecosistema dell'IA in cinque strati (layer) interdipendenti, ognuno dei quali rappresenta un nodo di potere economico e strategico. Comprendere questa stratificazione permette ai leader aziendali di mappare le dipendenze, identificare le vulnerabilità e posizionarsi in modo più consapevole.

Il primo strato è l'Hardware, che include i componenti fondamentali come i semiconduttori e i chip specializzati. Parliamo di GPU (Graphics Processing Units), prodotte da aziende come NVIDIA, o di TPU (Tensor Processing Units), sviluppate da Google, essenziali per le enormi potenze di calcolo richieste nelle fasi di addestramento e inferenza dei modelli. Questo mercato, altamente concentrato, è oggi una delle principali barriere all'ingresso e un'arena di forti tensioni geopolitiche, come dimostrano le analisi della Bank for International Settlements.

Il secondo layer è il Cloud Computing. Infrastrutture fornite da giganti come Amazon Web Services (AWS), Microsoft Azure e Google Cloud offrono la potenza di calcolo necessaria per addestrare e distribuire i modelli su larga scala. Il controllo di questo strato è strategico, poiché determina chi ha la capacità effettiva di sviluppare e operare modelli di IA avanzati. Attualmente, il dominio statunitense su hardware e cloud crea una forte dipendenza strutturale per le altre nazioni.

Segue il layer dei Training Data, i dataset usati per addestrare i modelli. La qualità, l'ampiezza e la provenienza dei dati sono decisive per le performance dell'IA. In un mondo in cui i dati sono un asset economico con rendimenti marginali crescenti, il loro controllo è un elemento centrale della competizione globale. Normative come il GDPR in Europa cercano di regolare i flussi di dati, definendo il concetto di sovranità digitale.

Il quarto strato è quello dei Foundation Models, i modelli pre-addestrati di grandi dimensioni come GPT di OpenAI, Llama di Meta o Gemini di Google DeepMind. La loro creazione richiede risorse computazionali e finanziarie immense, concentrando ulteriormente il potere tecnologico nelle mani di poche grandi aziende.

Infine, il quinto layer è quello delle AI Applications. Questo è il livello in cui l'IA diventa uno strumento concreto e trasformativo, con soluzioni verticali sviluppate per settori specifici come la sanità, la finanza o la manifattura. È qui che si manifesta il valore finale per le imprese e i consumatori. La Cina, consapevole della sua vulnerabilità negli strati infrastrutturali, sta investendo massicciamente per raggiungere l'autosufficienza su chip, dati e modelli, mentre l'Europa cerca di affermare la propria influenza tramite la regolamentazione, come l'AI Act, per definire standard applicativi affidabili e competitivi.

3. Capitale Umano e IA: Riconfigurare le Competenze nelle Strategie Aziendali IA

La trasformazione innescata dall'intelligenza artificiale sta investendo il mercato del lavoro non tanto con una distruzione netta di posti, quanto con una profonda e rapida riconfigurazione delle competenze richieste. Lo scenario che si delinea non è quello di una sostituzione di massa, ma di una transizione complessa. Il problema centrale, come evidenziato dal Future of Jobs Report 2023 del World Economic Forum, è un mismatch temporaneo tra le abilità oggi disponibili e quelle che i nuovi processi tecnologici domandano. Il report stima che il 44% delle competenze dei lavoratori cambierà nei prossimi cinque anni, una cifra che impone a ogni azienda una riflessione strategica sulla gestione del proprio capitale umano.

Per affrontare questa transizione, il concetto di lifelong learning (apprendimento continuo) diventa un imperativo categorico. Nazioni come Singapore, con il suo programma nazionale SkillsFuture, e la Finlandia stanno già sperimentando ecosistemi formativi distribuiti che abilitano la formazione continua lungo l'intero arco della vita lavorativa. Anche in Italia esistono strumenti come il Fondo Nuove Competenze, ma serve una strategia integrata che trasformi le organizzazioni in vere e proprie "learning companies", capaci di promuovere un aggiornamento costante delle abilità.

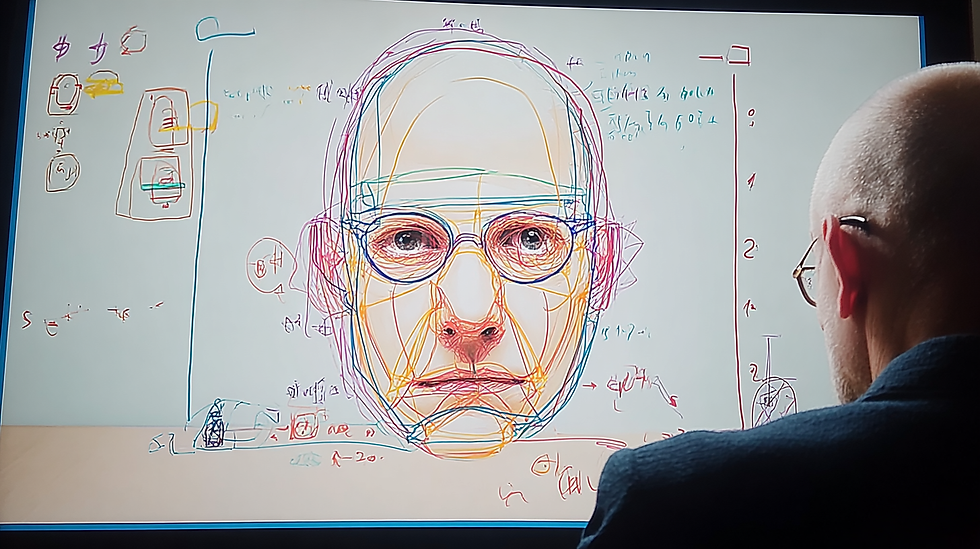

Le scuole e le università stesse sono chiamate a evolvere: da luoghi di trasmissione passiva di nozioni a palestre per il pensiero critico e l'intelligenza umana "aumentata". In questo scenario, emerge la necessità di non delegare acriticamente il pensiero ai sistemi "intelligenti". Il concetto di "Sistema 0", proposto dai ricercatori Massimo Chiriatti e Giuseppe Riva, descrive l'IA come un'estensione cognitiva esterna che elabora informazioni senza comprenderle. Ciò sottolinea l'importanza di mantenere l'essere umano al centro del processo di interpretazione e decisione, evitando un impoverimento cognitivo derivante da un'eccessiva dipendenza dalla tecnologia. Per le aziende, questo si traduce nella necessità di formare i propri team non solo all'uso degli strumenti di IA, ma anche a una supervisione critica e consapevole dei loro output.

La sfida, quindi, è principalmente umana e organizzativa. La sua gestione richiede una visione olistica, perché le strategie aziendali IA di successo vanno oltre la semplice implementazione tecnologica. È in questa fase che realtà consulenziali come Rhythm Blues AI diventano partner strategici per CEO e dirigenti. Attraverso un'audit iniziale e percorsi formativi modulari, si aiuta l'impresa a mappare le aree a maggior potenziale, a definire una roadmap di adozione sostenibile e a preparare la leadership e i team al cambiamento. L'obiettivo non è solo implementare la tecnologia, ma integrare l'IA in modo intelligente, definendo KPI chiari e misurando il ritorno sull'investimento per trasformare la sfida del mismatch di competenze in un'opportunità di crescita e competitività.

4. Oltre i Chatbot: Le Nuove Frontiere Tecniche per le Strategie Aziendali IA

Il 2024 ha segnato il consolidamento di alcune direttrici tecnologiche che stanno definendo il futuro prossimo dell'intelligenza artificiale. Per i leader aziendali, comprendere queste evoluzioni è fondamentale per distinguere le reali opportunità dalle mode passeggere. Le tre aree principali di avanzamento sono l'IA generativa, l'IA collaborativa e l'emergere di sistemi agentici sempre più autonomi.

L'IA generativa (GenAI) è senza dubbio la tecnologia che ha catturato maggiormente l'attenzione. Alla base di sistemi come Midjourney, DALL-E e dei modelli linguistici avanzati ci sono le reti neurali profonde e, in particolare, l'architettura transformer. Introdotta nel 2017, questa architettura permette di elaborare sequenze di dati (come testi o immagini) in parallelo, abilitando la creazione di contenuti multimediali di qualità sempre più elevata. Le prestazioni vengono poi affinate tramite tecniche come l'apprendimento per rinforzo (reinforcement learning), che premia il modello per le risposte considerate più utili, migliorandone progressivamente l'aderenza al contesto. Le applicazioni aziendali spaziano dalla creazione di contenuti marketing alla generazione di codice, fino alla comparsa di influencer interamente artificiali.

Parallelamente, si sta affermando il paradigma dell'IA collaborativa, che vede i sistemi intelligenti non come sostituti, ma come partner degli operatori umani. Il concetto chiave è quello di human-in-the-loop (HITL), un approccio che mantiene l'essere umano al centro del ciclo decisionale, specialmente in contesti critici come la sanità o la manifattura. L'essere umano supervisiona, interviene e migliora insieme al sistema, integrando la potenza computazionale dell'algoritmo con l'intuizione, il giudizio esperto e la responsabilità etica. Un esempio è la manutenzione predittiva nel settore aerospaziale, dove piattaforme come Airbus Skywise analizzano i dati dei sensori per prevedere guasti, ma la decisione finale sull'intervento spetta sempre all'ingegnere. Tecnologie come il federated learning (apprendimento federato), che consentono di addestrare modelli su dati decentralizzati senza condividerli, sono un altro esempio di come l'IA possa operare in modo collaborativo e rispettoso della privacy.

La frontiera più avanzata è rappresentata dall'Agentic AI. Si tratta di sistemi autonomi progettati per perseguire un obiettivo interagendo con l'ambiente. A differenza di un chatbot, un agente non si limita a rispondere, ma pianifica ed esegue azioni. La sua architettura si basa su tre livelli: un Model Layer (il "cervello", tipicamente un modello linguistico), un Tool Layer (che permette all'agente di usare strumenti esterni come API o database) e un Orchestration Layer (che governa il ciclo percezione-ragionamento-azione). Questi agenti, capaci di eseguire compiti complessi come la prenotazione di un viaggio o la gestione di una campagna marketing, anticipano alcune delle funzionalità della futura Intelligenza Artificiale Generale (AGI), l'obiettivo a lungo termine di creare macchine con una flessibilità cognitiva simile a quella umana.

5. Sostenibilità e IA: Integrare l'Impatto Ambientale nelle Strategie Aziendali IA

Mentre l'adozione dell'intelligenza artificiale accelera, emerge con sempre maggiore urgenza la necessità di confrontarsi con il suo impatto ambientale, un aspetto spesso trascurato nel dibattito pubblico ma cruciale per una crescita sostenibile. L'enorme potenza di calcolo richiesta dai modelli di IA, specialmente quelli di grandi dimensioni, si traduce in un consumo significativo di due risorse primarie: energia e acqua.

L'addestramento di un modello come GPT-3, con i suoi 175 miliardi di parametri, ha richiesto circa 1.287 MWh di elettricità, generando emissioni equivalenti a 552 tonnellate di CO₂, paragonabili a quelle di 123 auto a benzina in un anno. Modelli più recenti hanno un'impronta ancora maggiore, evidenziando una tendenza preoccupante. A questo si aggiunge il consumo energetico dei data center, le infrastrutture fisiche che ospitano questi sistemi, che rappresentano già tra il 2% e il 4% del consumo elettrico globale nelle principali economie.

Un altro costo nascosto è il consumo idrico. Il raffreddamento dei server, specialmente quelli dedicati all'IA, richiede enormi quantità d'acqua. Negli Stati Uniti, il consumo idrico dei data center è passato da 21,2 miliardi di litri nel 2014 a 66 miliardi di litri nel 2023, un aumento del 211% in meno di un decennio. L'impronta idrica varia a seconda della localizzazione geografica e delle tecnologie di raffreddamento, ma resta una sfida critica, specialmente in aree soggette a stress idrico.

Queste dinamiche devono essere inquadrate nel concetto di "rebound effect": i miglioramenti nell'efficienza energetica di un singolo calcolo non si traducono necessariamente in una riduzione del consumo totale. Anzi, la maggiore accessibilità e le nuove applicazioni possono portare a un aumento esponenziale dell'utilizzo, con un conseguente incremento del fabbisogno complessivo di risorse. Per le aziende, la sostenibilità dell'IA sta diventando un fattore di governance strategica, anche alla luce di nuove normative come la Corporate Sustainability Reporting Directive (CSRD) in Europa. Questa direttiva impone obblighi di rendicontazione più stringenti, basati sul principio della "doppia materialità": le imprese devono comunicare non solo come i fattori ambientali influenzano il loro business, ma anche come le loro attività impattano sull'ambiente.

Le grandi aziende tecnologiche stanno già rispondendo. Apple, nel suo Environmental Progress Report 2024, ha certificato i primi prodotti a zero emissioni di carbonio, mentre Samsung punta a raggiungere l'obiettivo net zero per le emissioni dirette e indirette entro il 2030, anche attraverso lo sviluppo di semiconduttori a basso consumo. Per ogni impresa che adotta l'IA, la sfida consisterà nell'integrare queste considerazioni nel proprio bilancio di sostenibilità, misurando l'impronta carbonica degli algoritmi, ottimizzando le infrastrutture e scegliendo modelli computazionali meno energivori, trasformando un potenziale rischio reputazionale in un'opportunità di innovazione responsabile.

6. Dalla "Black Box" alla Fiducia: Trasparenza e Responsabilità nelle Strategie Aziendali IA

Man mano che i sistemi di intelligenza artificiale vengono integrati in processi decisionali critici, dal merito creditizio alla diagnostica medica, emerge una delle sfide etiche e operative più complesse: il problema della "black box". Molti modelli avanzati, come le reti neurali profonde, operano in modi così complessi da risultare opachi persino per i loro stessi sviluppatori. Questa mancanza di trasparenza rende difficile comprendere perché un algoritmo ha preso una determinata decisione, sollevando interrogativi fondamentali su accountability (responsabilità), verifica e fiducia.

Il concetto di accountability implica la capacità di giustificare le proprie azioni a un'autorità o a un pubblico. Tradizionalmente, questo si basa su tre pilastri: chiarezza su chi è responsabile, meccanismi di controllo e verifica, e procedure di riparazione in caso di errore. L'IA scardina questi pilastri. La responsabilità diventa distribuita tra sviluppatori, fornitori di dati e utenti finali; l'opacità decisionale rende la verifica un'impresa ardua; e identificare la causa di un errore algoritmico per porvi rimedio può essere estremamente difficile.

Per affrontare questa sfida, sta crescendo un intero campo di ricerca e sviluppo noto come Explainable AI (XAI), o IA Spiegabile. L'obiettivo della XAI è sviluppare tecniche e modelli che rendano le decisioni algoritmiche più trasparenti e interpretabili. Questo non significa svelare i segreti commerciali, ma fornire una giustificazione comprensibile del processo decisionale.

Esistono diversi approcci:

● Tecniche di interpretabilità locale: Strumenti come LIME (Local Interpretable Model-agnostic Explanations) o SHAP (SHapley Additive exPlanations) analizzano come un modello ha reagito a un input specifico, identificando quali caratteristiche (variabili) hanno avuto il maggiore impatto sulla decisione finale. Ad esempio, possono spiegare perché a un cliente è stato negato un prestito evidenziando i fattori più influenti.

● Modelli intrinsecamente interpretabili: Invece di usare modelli "black box", si possono scegliere architetture più semplici, come gli alberi decisionali, che, pur essendo meno potenti in alcuni contesti, offrono una logica decisionale chiara e tracciabile.

● Documentazione e tracciabilità: Un approccio complementare è garantire che ogni fase del ciclo di vita dell'IA, dalla raccolta dei dati alla messa in produzione, sia meticolosamente documentata. Sistemi di audit e log digitali diventano essenziali per poter ricostruire, a posteriori, il percorso che ha portato a un risultato problematico.

Per le aziende, investire in trasparenza non è solo una questione di conformità normativa, ma un imperativo strategico. In settori regolamentati come la finanza e la sanità, la capacità di spiegare una decisione è un requisito legale. Più in generale, la fiducia di clienti, partner e dipendenti dipende dalla percezione che i sistemi automatizzati operino in modo equo e comprensibile. La tensione tra la necessità di proteggere la proprietà intellettuale degli algoritmi e l'esigenza di trasparenza può essere gestita attraverso una "trasparenza differenziata": informazioni tecniche dettagliate per i regolatori e spiegazioni semplificate ma significative per il pubblico. Costruire un framework di governance che includa la supervisione umana e meccanismi di intervento ("kill switch") è la chiave per evitare che la "black box" diventi una fonte di rischio incontrollato.

7. Bias e Sovranità Digitale: Le Sfide Sociali che Impattano le Strategie Aziendali IA

Oltre alle sfide tecniche e ambientali, l'integrazione massiva dell'IA nella società solleva profonde questioni etico-sociali che toccano i nervi scoperti delle nostre democrazie: l'equità, la privacy e la sovranità. Il rischio più insidioso è forse quello della discriminazione algoritmica, comunemente nota come bias. Gli algoritmi, infatti, non sono neutrali: apprendono dai dati con cui vengono addestrati. Se questi dati riflettono pregiudizi storici o disuguaglianze sociali, l'IA non solo li replicherà, ma potrà addirittura amplificarli, creando circoli viziosi di esclusione.

Un esempio emblematico è stato il caso della Apple Card nel 2019, emessa da Goldman Sachs. L'algoritmo di valutazione del credito fu accusato di discriminare le donne, concedendo loro limiti di spesa significativamente inferiori rispetto a uomini con profili finanziari analoghi. Sebbene l'algoritmo non utilizzasse esplicitamente il genere come variabile, aveva imparato a basarsi su "proxy" indiretti presenti nei dati storici, perpetuando di fatto una distorsione sistemica. Questo dimostra come il bias possa emergere anche in modo non intenzionale, rendendo cruciale un monitoraggio costante e l'adozione di tecniche per la sua mitigazione, come la diversificazione dei dataset e audit algoritmici periodici.

Un'altra sfida cruciale riguarda la privacy e la sicurezza dei dati. I sistemi di IA, per funzionare, necessitano di enormi quantità di dati, spesso personali. Questo li rende un bersaglio primario per gli attacchi informatici, il cui scopo non è più solo il furto di informazioni, ma anche la manipolazione dei modelli stessi (ad esempio, tramite "data poisoning" per alterarne il comportamento). Le statistiche mostrano una crescita allarmante delle minacce: nel primo semestre del 2024, gli attacchi informatici gravi a livello globale sono aumentati del 23% rispetto all'anno precedente, con gli attacchi rivolti a enti governativi cresciuti di oltre il 90%.

Questo ci porta alla questione della sovranità digitale e della crescente frammentazione di Internet. Invece di un'unica rete globale e aperta, stiamo assistendo all'emergere di ecosistemi digitali chiusi e nazionalizzati, spesso definiti "splinternet". La Cina ha costruito una rete altamente controllata; la Russia promuove piattaforme locali isolate; gli Stati Uniti hanno imposto restrizioni su applicazioni come TikTok. A questa frammentazione governativa si aggiunge la centralizzazione del potere nelle mani di pochi hyperscaler privati (come AWS, Google Cloud, Microsoft Azure) che controllano le infrastrutture cloud globali. Questa duplice tendenza – frammentazione statale e concentrazione privata – mina l'ideale di un internet aperto e pone le aziende di fronte a un panorama normativo e operativo sempre più complesso e incerto.

8. Antitrust e IA: Navigare le Regole della Concorrenza nelle Strategie Aziendali IA

L'ascesa dell'intelligenza artificiale non sta solo trasformando i processi produttivi, ma sta anche mettendo a dura prova le tradizionali regole della concorrenza. Le autorità antitrust di tutto il mondo, inclusi i leader del G7, hanno iniziato a esprimere serie preoccupazioni riguardo al rischio di una eccessiva concentrazione di potere di mercato nelle mani di poche grandi piattaforme tecnologiche. L'accesso a risorse critiche come dati, chip specializzati e infrastrutture cloud è di fatto controllato da un numero ristretto di attori, creando colli di bottiglia che potrebbero ostacolare l'ingresso di nuovi competitor e soffocare l'innovazione.

Una delle pratiche anticoncorrenziali più monitorate è il self-preferencing, ovvero la tendenza di una piattaforma dominante a favorire i propri prodotti e servizi a scapito di quelli di terzi. Un caso di studio attuale è l'introduzione di AI Overview da parte di Google. Tradizionalmente, il motore di ricerca indirizzava gli utenti verso siti esterni. Oggi, fornendo risposte generate dall'IA direttamente nella pagina dei risultati, Google rischia di trattenere il traffico, con un potenziale impatto negativo sulla sostenibilità economica degli editori e dei creatori di contenuti, che vedono diminuire le loro entrate pubblicitarie. Questo solleva interrogativi sull'equità del mercato e sulla pluralità delle fonti di informazione, aspetti che normative come il Digital Markets Act (DMA) in Europa cercano di affrontare.

Un altro rischio emergente è quello della collusione algoritmica. Se più aziende utilizzassero algoritmi di pricing simili, questi potrebbero "imparare" a coordinarsi per mantenere i prezzi alti, anche senza un accordo esplicito, creando di fatto un cartello digitale. Questa minaccia si estende anche al mercato del lavoro. Le autorità di concorrenza stanno ponendo crescente attenzione ai cosiddetti no-poaching agreements, accordi con cui le aziende si impegnano a non assumere i dipendenti l'una dell'altra, limitando la mobilità dei talenti e deprimendo i salari.

Un'indagine della Commissione Europea ha coinvolto le società di food delivery Delivery Hero e Glovo, sospettate di aver stretto un accordo di questo tipo, culminato in una sanzione di 329 milioni di euro nel giugno 2025. Questo caso dimostra come le pratiche anticoncorrenziali non riguardino solo i prezzi al consumo, ma anche le dinamiche del mercato del lavoro, specialmente in settori ad alta intensità tecnologica. Per le aziende, navigare questo scenario richiede non solo innovazione, ma anche una profonda consapevolezza dei limiti imposti dalle normative antitrust, per evitare che la ricerca di un vantaggio competitivo si traduca in pratiche che distorcono il mercato e attirano l'attenzione dei regolatori.

9. Il Labirinto Normativo: Come l'AI Act Influenza le Strategie Aziendali IA

L'intelligenza artificiale, per sua natura globale, si scontra con un panorama normativo sempre più frammentato. Le principali potenze economiche stanno sviluppando approcci regolatori che riflettono le loro diverse filosofie politiche ed economiche, creando un complesso mosaico di obblighi e standard con cui le aziende internazionali devono confrontarsi.

L'Unione Europea ha assunto un ruolo pionieristico con l'adozione dell'AI Act (Regolamento (UE) 2024/1689), entrato formalmente in vigore nell'agosto 2024. Questo regolamento introduce un approccio orizzontale e basato sul rischio, che classifica i sistemi di IA in diverse categorie:

● Rischio inaccettabile: Pratiche vietate, come i sistemi di social scoring o la manipolazione comportamentale subliminale. Queste norme sono applicabili dal febbraio 2025.

● Rischio alto: Sistemi utilizzati in settori critici (es. sanità, infrastrutture, giustizia) che devono rispettare requisiti stringenti su trasparenza, sorveglianza umana e gestione dei dati. Le norme per questi sistemi entreranno in vigore nell'agosto 2026.

● Rischio limitato e minimo: Sistemi che richiedono obblighi di trasparenza (es. chatbot che devono dichiarare di essere artificiali) o che sono soggetti solo a codici di condotta volontari.

A questo si affianca il Data Act (Regolamento (UE) 2023/2854), che diventerà applicabile dal 12 settembre 2025 e mira a creare un mercato unico dei dati, regolando l'accesso e la condivisione delle informazioni generate da prodotti connessi (IoT).

Negli Stati Uniti, l'approccio è storicamente più orientato all'autoregolamentazione e all'innovazione guidata dal settore privato. Con l'insediamento della nuova amministrazione a gennaio 2025, è stato revocato il precedente ordine esecutivo sull'IA, sostituito da una nuova politica che mira a "rimuovere le barriere alla leadership americana" e a sviluppare sistemi liberi da "bias ideologici". A livello federale manca una legge onnicomprensiva simile all'AI Act, ma si sta assistendo a un'intensa attività legislativa a livello statale. La California, ad esempio, ha visto il veto a una proposta di legge molto discussa (SB-1047), mentre altri stati come Colorado e Utah hanno già approvato normative specifiche sulla protezione dei consumatori nell'interazione con l'IA, che entreranno in vigore nel 2026.

La Cina adotta un modello fortemente diretto dallo Stato, con l'obiettivo strategico di diventare leader mondiale nell'IA entro il 2030. La regolamentazione cinese è più settoriale e si concentra sul controllo dei contenuti e sulla sicurezza nazionale. Norme specifiche già in vigore regolano gli algoritmi di raccomandazione e i servizi di "sintesi profonda" (deepfake), richiedendo la registrazione degli algoritmi presso l'autorità centrale. Recentemente, il governo ha pubblicato un AI Safety Governance Framework, un documento di indirizzo che, pur non essendo vincolante, delinea i principi per uno sviluppo sicuro ed etico della tecnologia, suggerendo un approccio anch'esso basato sul rischio. Parallelamente, il paese sta dimostrando una crescente capacità innovativa, con modelli come DeepSeek che competono a livello globale per performance ed efficienza.

10. L'Adozione in Italia: Dati e Tendenze per le Strategie Aziendali IA Nazionali

I dati raccolti attraverso una consultazione empirica rivolta a un panel qualificato di aziende italiane offrono uno spaccato chiaro e significativo dello stato di adozione dell'intelligenza artificiale nel nostro tessuto industriale. Il dato più eclatante è la forte accelerazione registrata nell'ultimo anno: la percentuale di aziende che hanno avviato iniziative concrete basate sull'IA è passata dal 30% del 2024 al 67% del 2025. Questo balzo indica che l'IA non è più percepita come una tecnologia futuribile, ma come uno strumento operativo e strategico per il presente.

Analizzando le aree di applicazione, emerge che l'adozione è trainata principalmente dalla ricerca di efficienza. L'automazione dei processi amministrativi (17 risposte) e del servizio clienti (16 risposte) sono gli ambiti più comuni, seguiti dall'analisi dei dati e dal marketing. Di conseguenza, i benefici strategici più riconosciuti sono l'aumento dell'efficienza operativa (22,6% delle risposte), l'accelerazione dell'innovazione e la riduzione dei costi. Le imprese vedono nell'IA una leva concreta per ottimizzare le risorse e migliorare la competitività.

Tuttavia, il percorso di adozione non è privo di ostacoli. Le sfide principali non sono di natura puramente tecnologica, ma organizzativa e umana. La formazione del personale e la gestione dei dati sono indicate come le barriere più critiche (entrambe con il 14,6% delle risposte), seguite dalla difficoltà di integrazione con i sistemi esistenti. Questo conferma che il successo delle strategie aziendali IA dipende in larga misura dalla capacità di sviluppare competenze interne e di disporre di un'infrastruttura dati solida e ben gestita.

Nonostante le sfide, la visione per il futuro è decisamente ottimista. L'86% delle aziende intervistate ha intenzione di estendere l'utilizzo dell'IA in altre aree, con un focus particolare su sicurezza informatica, ricerca e sviluppo e un'ulteriore automazione del servizio clienti. Questa volontà di espansione, però, si scontra con alcune debolezze strutturali del sistema.

Finanziamento e Supporto all'Adozione dell'IA in Italia | Percentuale Risposte |

Fonte di Finanziamento Prevalente |

|

Fondi Interni | 71% |

Partnership con Istituti di Ricerca | 12,5% |

Finanziamenti Pubblici / Venture Capital | 8,3% |

Percezione del Supporto Governativo |

|

Supporto Insufficiente | 59% |

Supporto Esistente ma Migliorabile | 37% |

Supporto Significativo | 4% |

Come mostra la tabella, la stragrande maggioranza delle imprese (71%) finanzia i progetti di IA con risorse proprie, evidenziando una scarsa capacità di attrarre capitali esterni o di intercettare incentivi pubblici. Coerentemente, il 59% degli intervistati ritiene insufficiente il sostegno da parte del governo per incoraggiare l'adozione dell'IA, segnalando la necessità di politiche industriali più incisive e mirate per sostenere la trasformazione digitale del paese.

11. Conclusioni: Governare la Trasformazione, il Cuore delle Strategie Aziendali IA

L'intelligenza artificiale si sta consolidando non come una semplice tecnologia, ma come una vera e propria infrastruttura portante della prossima fase dello sviluppo economico e sociale. Il suo impatto può essere paragonato a quello dell'elettricità o di Internet, ma con una differenza sostanziale: l'IA non automatizza solo processi fisici o la trasmissione di informazioni, ma interviene direttamente sulle attività cognitive, un dominio finora esclusivo dell'essere umano.

Questa peculiarità impone a imprenditori e dirigenti un cambio di prospettiva. Non si tratta più di chiedersi se adottare l'IA, ma come governarne l'integrazione per generare valore sostenibile. Le analisi e i dati presentati mostrano chiaramente che la sfida non è tecnologica, bensì strategica, organizzativa ed etica. Le aziende che avranno successo non saranno quelle che implementeranno il maggior numero di algoritmi, ma quelle che sapranno costruire un ecosistema in cui l'intelligenza artificiale e l'intelligenza umana lavorano in sinergia.

Lo stato dell'arte e le tecnologie concorrenti, come i sistemi di automazione tradizionali o le piattaforme di analisi dati, offrono soluzioni a problemi specifici e ben definiti. L'IA, al contrario, introduce un potenziale di apprendimento e adattamento continuo che apre a possibilità inedite, ma anche a rischi di opacità, bias e perdita di controllo. La vera leadership, oggi, consiste nel trovare un equilibrio. Significa investire non solo in software e hardware, ma soprattutto nel capitale umano, trasformando la formazione da costo a investimento strategico. Significa disegnare nuovi modelli organizzativi che prevedano una supervisione umana consapevole, evitando la trappola di una delega acritica agli algoritmi. Significa, infine, costruire una solida governance interna che definisca principi etici chiari, garantisca la trasparenza e misuri l'impatto delle decisioni automatizzate.

La traiettoria è tracciata: l'IA diventerà pervasiva. Le imprese che si limiteranno a una sperimentazione superficiale rischiano di rimanere ai margini, mentre quelle che sapranno governare la complessità di questa trasformazione, coniugando efficienza operativa e responsabilità, potranno definire nuovi standard di competitività e costruire un vantaggio duraturo.

Se desideri approfondire come la tua azienda possa navigare questa trasformazione in modo strategico e consapevole, ti invitiamo a un confronto diretto. È un momento di scambio che permette di valutare i bisogni specifici della tua organizzazione e di iniziare a costruire un piano d'azione personalizzato e orientato alla crescita.

Per prenotare una consulenza iniziale gratuita di 30 minuti con Rhythm Blues AI e scoprire come l'intelligenza artificiale possa fornire un contributo concreto ai tuoi progetti, fissa un appuntamento al seguente link: Fissa una consulenza gratuita

12. FAQ: Risposte Rapide per le Tue Strategie Aziendali IA

1. Cos'è l'AI Act europeo e cosa significa per la mia azienda?

L'AI Act è il regolamento dell'Unione Europea che stabilisce regole armonizzate sull'intelligenza artificiale. Adotta un approccio basato sul rischio, imponendo obblighi diversi a seconda del potenziale impatto dei sistemi di IA. Per la tua azienda, significa che se sviluppi o utilizzi sistemi di IA, specialmente in aree "ad alto rischio" (come sanità, HR, credito), dovrai rispettare requisiti specifici di trasparenza, qualità dei dati e sorveglianza umana.

2. Qual è il primo passo concreto che un'impresa dovrebbe fare per adottare l'IA?

Il primo passo non è tecnologico, ma strategico. È consigliabile partire con un'audit delle attività aziendali per identificare i processi dove l'IA può generare il maggior valore (es. ottimizzazione di attività ripetitive, analisi di dati, miglioramento del customer service). Questo permette di definire un progetto pilota circoscritto, con obiettivi chiari e misurabili.

3. Come si può misurare il Ritorno sull'Investimento (ROI) di un progetto di IA?

Il ROI di un progetto di IA si misura definendo fin dall'inizio Key Performance Indicators (KPI) specifici. Questi possono includere metriche di efficienza (es. riduzione dei tempi di processo, diminuzione dei costi operativi), di efficacia (es. aumento delle vendite, miglioramento della soddisfazione del cliente) o di innovazione (es. velocità di sviluppo di nuovi prodotti).

4. L'IA sostituirà i posti di lavoro nella mia azienda?

Le evidenze attuali suggeriscono che l'IA non porterà a una distruzione netta dei posti di lavoro, ma a una loro profonda riconfigurazione. Automatizzerà alcune mansioni, soprattutto quelle ripetitive, ma creerà nuove professioni e richiederà nuove competenze. La vera sfida è gestire la transizione attraverso la formazione continua (reskilling e upskilling) del personale.

5. Cos'è il "bias algoritmico" e come posso evitarlo?

Il bias algoritmico è una distorsione nei risultati di un sistema di IA, causata da pregiudizi presenti nei dati di addestramento. Per evitarlo, è fondamentale utilizzare dataset diversificati e rappresentativi, effettuare audit periodici degli algoritmi per identificare eventuali discriminazioni e implementare una supervisione umana che possa correggere le decisioni inique.

6. Devo sviluppare una soluzione di IA interna o acquistare una soluzione già esistente?

La scelta dipende dalle risorse e dagli obiettivi. Acquistare una soluzione esistente è più rapido e richiede meno competenze tecniche interne, ed è ideale per applicazioni standard. Sviluppare una soluzione interna offre maggiore personalizzazione e controllo, ma richiede investimenti significativi in termini di tempo, costi e talenti specializzati. Molte aziende adottano un approccio ibrido.

7. Qual è l'impatto ambientale dell'IA e come può la mia azienda essere più sostenibile?

L'IA ha un'impronta ambientale significativa a causa dell'elevato consumo di energia e acqua dei data center. Per essere più sostenibile, un'azienda può scegliere fornitori di cloud che utilizzano energie rinnovabili, ottimizzare i modelli per renderli meno energivori e adottare pratiche di green computing. La rendicontazione di questi impatti sta diventando un requisito normativo (es. CSRD in Europa).

8. Cosa si intende per "IA Spiegabile" (XAI) e perché è importante?

L'IA Spiegabile (Explainable AI) è un insieme di tecniche che mirano a rendere comprensibili le decisioni prese da modelli di IA complessi (spesso definiti "black box"). È importante per garantire la fiducia degli utenti, la conformità normativa (specialmente in settori regolamentati) e per poter identificare e correggere errori o bias.

9. Come posso proteggere i dati della mia azienda e dei miei clienti quando uso l'IA?

La protezione dei dati è cruciale. È necessario adottare misure di cybersecurity avanzate, utilizzare tecniche di anonimizzazione o pseudonimizzazione dei dati, e assicurarsi di rispettare normative come il GDPR. Tecnologie come il federated learning permettono di addestrare modelli senza centralizzare i dati sensibili, offrendo un ulteriore livello di protezione.

10. Quali sono le competenze più richieste per lavorare con l'IA?

Oltre alle competenze tecniche come programmazione (Python), machine learning e gestione dei dati, sono sempre più richieste competenze trasversali. Queste includono il problem solving, il pensiero critico (per valutare gli output dell'IA), la conoscenza del dominio di business specifico e competenze etiche per governare l'uso responsabile della tecnologia.

Commenti